多方反对下 苹果放弃了检测iCloud照片中已知CSAM的计划

根据与WIRED分享的一份声明,苹果今天宣布,它已经放弃了检测存储在iCloud照片中的已知CSAM(儿童性虐待内容)的计划。苹果在一份声明中写道:"在广泛征求专家意见,收集我们去年提出的儿童保护举措的反馈意见后,我们正在深化我们对2021年12月首次提供的通信安全功能的投资,"

苹果表示,"我们决定不推进我们之前提出的iCloud照片的CSAM检测工具。儿童可以在没有公司梳理个人数据的情况下得到保护,我们将继续与政府、儿童倡导者和其他公司合作,帮助保护年轻人,维护他们的隐私权,并使互联网成为儿童和我们所有人更安全的地方。"

2021年9月,苹果在其儿童安全页面发布了以下更新:“之前我们宣布了一些功能计划,旨在帮助保护儿童免受使用通信工具招募和剥削他们的掠夺者的侵害并帮助限制儿童性虐待材料的传播。根据客户、宣传团体、研究人员和其他人的反馈,我们决定在未来几个月内花更多时间收集意见并进行改进,然后再发布这些极其重要的儿童安全功能。”

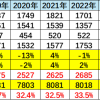

苹果计划向美国家失踪与被剥削儿童中心(NCMEC)报告有已知CSAM图像哈希值的iCloud账户,该中心是一个跟美国执法机构合作的非营利组织。苹果表示,将有一个“门槛”来确保“每年少于一万亿分之一的机会”的账户被系统错误标记,另外还有人工审查标记的账户。

苹果的计划受到了广泛的个人和组织的批评,这当中包括安全研究人员、电子前沿基金会(EFF)、政治家、政策团体、大学研究人员甚至一些苹果自己的员工。

一些批评者认为,苹果的儿童安全功能可能为设备创造一个“后门”,政府或执法机构可以利用它来监视用户。另一个问题是误报,包括有人可能故意将CSAM图像添加到另一个人的iCloud账户中从而使其账户被标记。