iPhone 15又秒光!凭啥?深度解密九大硬核技术

iPhone 15 Pro抢到了吗?根据苹果官网信息,现在买iPhone 15 Pro Max的最早发货日期已经延到了11月初。虽然目前首批预售数据还未公布,但此前仅京东单一电商平台iPhone 15系列的预约量就已经超过了300万。

苹果官网销售信息

天风证券分析师郭明錤刚刚发文称,iPhone 15 Pro Max的销量再次超过了去年的14 Pro Max,至于华为对于苹果销量的影响,他认为“还需观察”,今年他对于iPhone 15系列的预估仍然维持在8000万部,对于华为2024年手机销量预测约为6000万部。

此次开售,有不少人对苹果的表现感叹道:网上没赢过,销量没输过。

iPhone 15系列到底强不强、好不好、有没有创新、值不值这个价?

面对华为的“遥遥领先”,苹果真的如一些人说所,只是“序列号”更新了一下吗?

纵观苹果这场秋季春晚,包括CEO库克在内的12位苹果高管,用82分钟,呈现了7款产品和4颗芯片,同时揭开了一系列酝酿已久的新技术的神秘面纱。

但这些新技术究竟对消费者和产业意味着什么,有多少是“遥遥领先”,有多少是在“跟上Android不掉队”,又有多少是真正的“硬核创新”?

通过深扒技术细节、专利并与产业人士深入交流,我们尝试通过回答9个关键问题,还原一个更真实的iPhone 15系列,并尝试找到更有价值的产业观察。

深入“拆解”之下,我们发现很多细节问题都值得思考:

1、十年一换的接口和专业影像升级如何改变创作产业?

2、钛合金中框为什么是“钛包铝”,中框与屏幕工艺如何结合实现最窄边框?

3、打破此前Android所有既有方案的“潜望镜”到底藏着怎样的黑科技?

4、苹果对于长焦拍摄的思考和定位与Android阵营为何截然相反?

5、芯片命名改变的背后暗示着苹果怎样的潜在规划?

6、GPU对光追、MetalFX的支持是否会加速游戏产业两大生态的融合?

7、手机手表与Vision Pro的深层联动还有哪些想象空间?

8、3D空间视频拍摄又是否会成为影像创作产业的下一个风口?

9、AI大模型时代,苹果为潜在的“AI大招”都做了哪些铺垫?

每一个问题背后,往往是一些足以撬动一个新兴产业的细节升级,从消费电子、影视创作、游戏开发到芯片半导体、人工智能。拨开“吐槽大会”的外衣,静下心来,我们或许仍能发现一些苹果的“颠覆性创新”。

这周五新iPhone就要正式开售了,掏钱或者不掏钱,有些事还是看清楚点好。

01.

C口打通设备连接,存储瓶颈不再,与头显结合或有更多应用

讨论最多的新特性之一,就是USB-C口的更换,上次苹果更新手机接口,还是在2012年。

2007年苹果发布的第一款iPhone用的是30pin接口,接口还需要区分正反面,同期Android用的则是MicroUSB接口;五年后,苹果于2012年的iPhone 5上更换了Lightning接口,而这一用就是11年。

不知道这次的USB-C,能坚持多久。

发布会结束后,不少人都挂出了苹果官网“童叟无欺”的243元的USB-C转Lightning接口。

但相比关注苹果配件生意多赚钱,更值得关注的,显然是这个C口到底能做什么。

传输速率的提升,真的只是更快了吗?事实上,对于普通用户来说,我们已经很少用USB线来传输数据了。

当年3G换4G的时候,很多人也没有想到后面催生出的外卖和网约车产业。

实际上,这个USB-C口对于很多有高质量视频拍摄、存储需求的用户来说,是“刚需”。

这个C口不止有10Gb/s的数据传输速度,它可以连接移动硬盘、U盘这类高速外置存储设备,可以连接4K显示器和麦克风。

最直观的一点改变就是,这解决了ProRes视频拍摄时存储空间捉襟见肘的问题。对此一些专业人士评论道,“能够将iPhone实时拍摄的ProRes视频直接存到外接硬盘,这绝对算是个骚操作了。”

苹果官方宣传视频中的一个片段可以很好地展示外接存储带来的便利:

PS:友商三星的移动硬盘比苹果的官方存储便宜多了。

此外,苹果也把ProRes 4K视频拍摄的帧率限制从30fps开放至60fps。同时,iPhone可以通过C口与Mac电脑相连,拍摄素材在Mac中进行剪辑,流程打通。

诚然大部分专业视频创作仍然需要专业相机,但移动影像发展至今,以iPhone 14 Pro的视频拍摄能力为例,其已经可以满足很多独立创作者以及拍摄爱好者的需求。

对于用iPhone进行视频创作的用户来说,C口某种程度上为他们解放了一些创作上的限制。

甚至有专业创作人士认为,这可能是这次iPhone 15中对他影响最大的升级。

当然,这个C口还可以接的设备也不排除苹果的Vision Pro。

发布会上,苹果也提及用iPhone 15 Pro拍摄空间视频,直接在Vision Pro上播放,空间视频对于存储的需求目前仍不清楚,但可以预见的是,如果未来苹果Vision Pro中的某项功能需要手机与头显的高效协同,涉及数据的高速、低延时传输,这次的C口升级显然也埋下了伏笔。

所以看似苹果只是换了个接口,但在实际应用层面,苹果确实搞出了一些不一样的玩法。

不过话说回来,虽然升级了C口,但这个20W的充电速度没有变,着实没啥可洗的。

02.

一个中框能做出“四层”,悄悄用上新工艺,小米OV们都要跟进

看过发布会的人可能都有印象,苹果对于这次的钛合金中框,花了不少篇幅介绍,甚至单独请了一位苹果材料科学工程师Yang来进行解读。

大家都知道钛这种金属很好,但实际上将它做到手机中框里,可能并没有想象中那样容易,事实是,苹果是第一个将钛合金大规模应用于手机中框里的。

苹果是怎么加工的?从演示视频来看,苹果实用了一种叫“固态扩散”的技术,利用热机械加工工艺,以超高压将钛金属和铝金属接合在一起,在接合面上,两种金属在原子层面是相互“扩散”的。

这项工艺技术,在智能手机产业中尚属首次。

所以严格意义上来讲,苹果这个钛合金中框,是“钛包铝”的结构。用苹果的话来说,这一方面有助于热量传导,同时金属铝均为回收材料,也满足了苹果的环保需求。

为什么会有利于热量传导?这里不妨回顾下物理知识:纯钛的导热系λ=15.24W/(m·K),大约是铝的1/14,而钛合金的导热系数要比纯钛再低15%。

所以又想坚固轻盈,又想散热好,苹果最终想到了这种“套娃”的工艺,脑洞着实不小,工艺难度也上了一个新台阶。

其实相比于“更结实”了,这个中框还有两个容易被忽视的作用,一个是让手机更轻,一个是与屏幕封装技术配合,实现更窄边框。

iPhone 15 Pro这次的重量是187克,上代iPhone 14 Pro的重量是206克。6.7英寸iPhone 15 Pro Max在相比上代更换了体积更大的5倍长焦镜头后,重量还轻了20克。

苹果全球市场营销高级副总裁Joswiak在发布会上说,苹果让手机在屏幕尺寸不变的前提下,机身尺寸更小了。实际上,很少有人注意到,iPhone 15 Pro的纵向长度缩短了0.9毫米,宽度则窄了0.9毫米。

也就是说,当你拿起Pro版的时候,你不仅会明显觉得更轻了,可能还会觉得略小了一些,握持感更好了。

如果我们简单计算,屏幕尺寸不变,那么屏幕边框则至少要窄了0.45毫米。

正如Joswiak说的,这是他们迄今为止“最轻的Pro”,也是迄今为止边框最窄的iPhone。

彭博社此前有报道称,苹果可能是采用了名为“LIPO(低压注塑成型)”的技术来实现边框的收窄,但苹果并没有在发布会上具体透露他们是如何实现的。

值得注意的是,这个钛合金中框的新工艺不只在于加工钛合金这件事上,细心的人可以发现,与去年的不锈钢中框相比,今年的钛合金中框上增加了拉丝纹理。

苹果说,他们用了精密机械加工、打磨、拉丝、喷砂等多道工序来制作这一“刷痕纹理”,此外,在纹理之上,苹果实用了PVD涂层进行最后的保护,这一涂层的精度在纳米级,苹果说这道“涂膜”的工序耗时要14个小时。

增加拉丝工艺看上去是一个很细节的事,但是很好地解决了金属中框容易沾染指纹的问题,苹果确实是在一点点解决用户日常反馈的问题。

简单看上去就是一个钛合金中框,但这样捋下来,这个中框至少有上面提到的这“四层”:PVD、拉丝纹理、钛、铝。

这背后,以苹果的规模效应所带来的产业侧工艺提升,似乎很快就要应用到其他智能手机厂商的产品中了。

根据业内信息,年底国内各家旗舰机大概率都会在“新材料”方面做文章,比如小米在未来的旗舰机产品中也会采用钛合金工艺。

03.

到底怎么把七个镜头赛进一部手机里?苹果影像拥抱“专业性”

聊完了最显而易见的两个改变,我们来看看拍照部分。

乍看上去,今年iPhone 15 Pro以及Pro Max的三摄,似乎跟去年的外观并无差别,没有变得更大,位置布局也依然是等边三角形。

但苹果在发布会上总结说,他们这次核心做了一件事,就是把七个专业镜头塞到了一部手机中。

很多人感叹iPhone近年来外观变化并不大,但这从另一个角度来看,似乎恰恰是苹果擅长做的一件事:在尺寸几乎不变甚至略微缩小的机身内,将更多的新特性放到产品中,同时保证产品体验的完善性和一致性。

有一个发布会上苹果没有提到的细节,引起了很多业内人士的关注:苹果的这“七个镜头”,其中部分焦段是数码裁切出来的,但是所有焦段的拍摄功能都是完善一致的,比如人像模式的自动对焦功能,在各个焦段选项下都可以实现。

有业内人士透露,实现这样的一致性是非常难的,目前在Android阵营中并没有厂商能够实现同样的体验。

此外,苹果提到这次的4800万像素主摄具备了一个新功能,苹果的光像引擎会从一张超高分辨率图像中选出最佳的像素部分,再与另一张为捕捉光线而优化的图像融合,自动生成2400万像素的照片,分辨率是以往两倍。

目前虽然Android阵营的旗舰机主摄基本都是5000万像素起步,1亿像素甚至2亿像素也并不罕见,厂商们也都会在发布会上强调传感器尺寸之大、像素之高,但当我们真正拿到手进行拍摄时,默认拍出来的照片通常仍然是1200万像素。

我们常常听到的像素四合一、像素九合一,就是在做这样一件事。

比如常见的5000万像素主摄拍摄的照片,分辨率通常是4096*3072,像素数为1258万,乘以4,约等于5000万。

某Android旗舰手机主摄成片的详细信息

如果你不知道自己手机拍照到底是什么规格,不妨打开手机相册查看一下照片的详细信息,会有更直观的理解。

所以苹果的2400万像素,虽然听起来并不“吓人”,但实际上已经足够清晰了。清晰到什么程度?一台4K显示器的屏幕像素数大约是823万,苹果的一张照片,可以像素点对点地铺满大约3台4K显示器。

此外如何在拍摄的一瞬间完成一张超高分辨率图像与另一张光线信息图像融合,最终实现2400万像素成像,具体实现方式也值得进一步挖掘。

值得一提的是,苹果这次支持4800万像素成片以HEIF格式存储,在照片清晰度不变的前提下,存储空间占用更小。根据公开资料,同一张照片以HEIF格式存储,相比传统JPG、JPEG等格式大约要节省50-60%的空间。

HEIF与JPEG格式照片存储空间占用对比(HEIF 格式默认文件扩展名为 .HEIF或.HEIC)

这次在拍照方面,“专业性”的提升是一个比较容易被忽略的点。实际上,苹果在不断把iPhone向“专业摄影”的方向上去推。

比如在专业摄影方面,苹果在ProRes的基础上新增了Log模式编码功能,增加了后期视觉特效和调色制作的空间和灵活度。

苹果设备的色彩管理一直是消费电子领域的“天花板”,这次iPhone 15 Pro是手机领域第一个支持学院色彩编码系统(ACES)的产品,而ACES是电影制作领域的一种专业色彩管理和交互系统,被很多主流电影制作公司所采用。

一位专业影视制作领域工作者告诉智东西,其实目前iPhone 14 Pro的视频拍摄能力已经可以满足几乎所有拍摄需求,可以实现创作者任何天马行空的创意,这一点是很多普通用户都接触不到的。

结合前文接口部分所提到的USB-C带来的高速率及外接设备能力,此次iPhone在专业影像创作能力方面的提升,可以说是一个被大部分普通用户忽略的大招。

最后,关于空间视频的拍摄,这一功能也验证了不少人三个月前的猜想。

苹果Vision Pro与iPhone的联动,是必然的,Vision Pro和Mac、Apple Watch、AirPods等苹果生态设备的联动,也已成为既定事实。

拍摄3D空间视频的原理并不难理解,就像我们捂住一只眼睛,世界就会变成二维的一样,3D成像最基本的要素之一,就是有两枚摄像头参与。

当我们横向握持手机时,主摄和超广角镜头刚好会形成“双目视野”,从而拍摄3D空间视频。

此前Vision Pro发布时,很多人“吐槽”带着头显拍视频会比较“奇怪”,如今答案揭晓,用手机拍摄这种最自然的方式去拍摄3D空间视频仍然是可以的。

我们不禁可以想象,未来视频创作是否也会从平面转向3D,这对于影视创作产业似乎又在酝酿着一场新的风暴。

苹果这次可以说是先开了一扇小门,让我们看到了Vision Pro与iPhone联动的一个简单侧面,更多的想象空间,都留给了明年初的正式发布。

04.

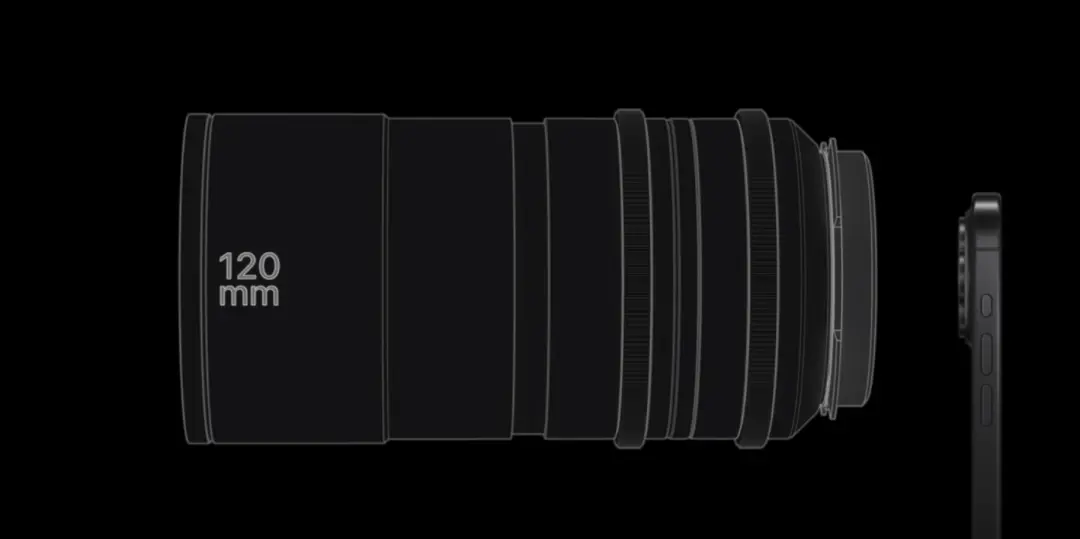

比起120倍,苹果更关心120毫米,长焦内部结构暗藏玄机

说完了主摄,我们来看看Pro Max上新增的这枚长焦镜头,也就是很多报道中提到的“潜望式镜头”。

关于这枚镜头,有一点比较有意思,就是苹果对于它的定位。

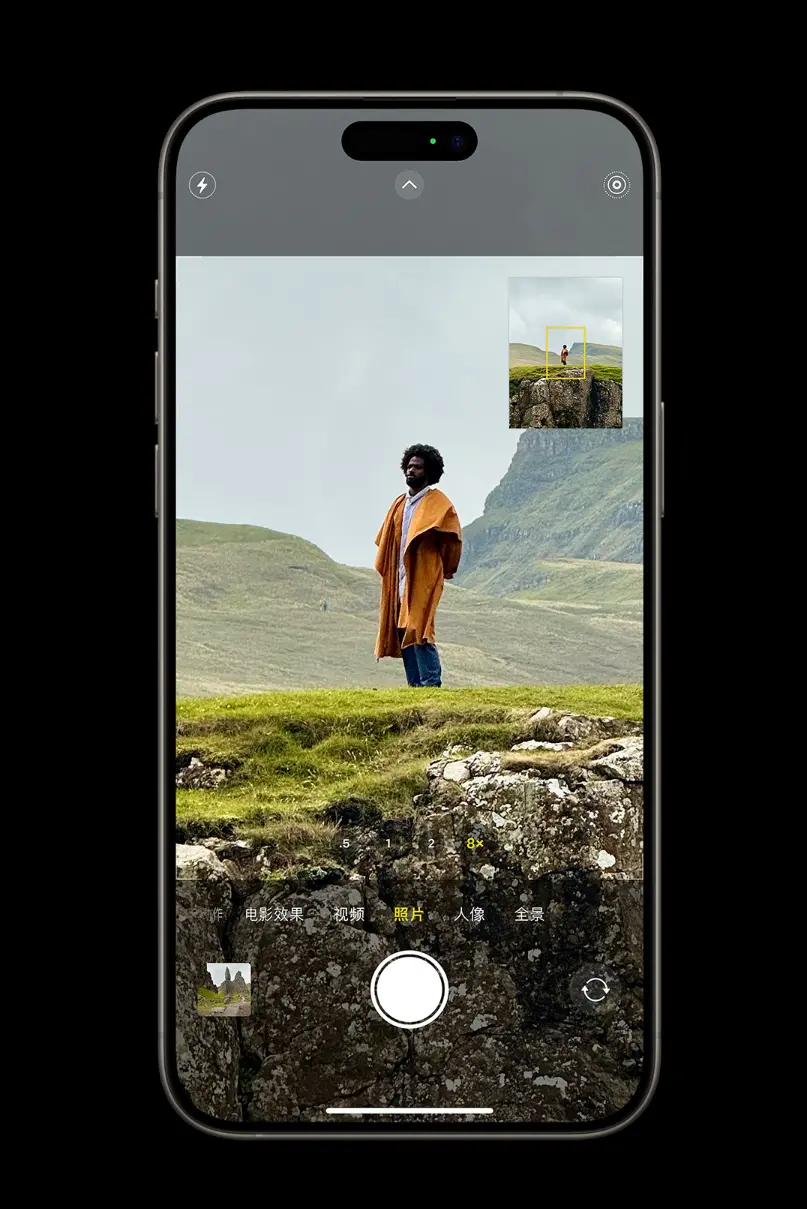

相比我们常常在Android阵营中看到的“百倍变焦”大战,100倍、120倍变焦,苹果更看重的是“120毫米”。

用苹果的话来说,你相当于多随身带了一个“120毫米焦距镜头”,并且苹果认为,120毫米是一个非常实用的焦段。这与我们此前对于潜望式镜头的印象截然相反。

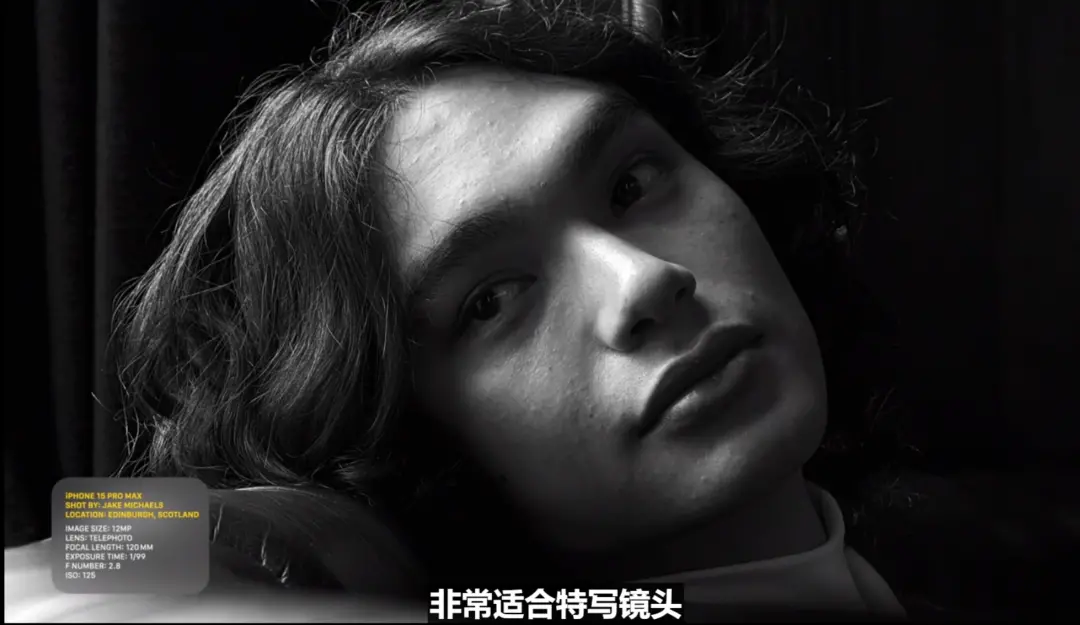

相比拍800米开外高楼上的一扇窗户、数百米外街道上的车辆行人、夜晚天空中的一轮圆月,苹果认为这枚长焦镜头更适合拍摄“特写”,比如大片感十足的人物近照、孩子在比赛中的精彩进球。

甚至苹果在发布会上全程只提及了5倍光学变焦能力。

大家都知道,支持5倍光学变焦的镜头,是可以通过进一步的数码裁切得到100倍、120倍图像的,但苹果显然也把这件事看的很明白,相比100倍放大后的模糊图像,为这枚长焦找到一个合适的定位,是非常关键的一件事。

在苹果做之前,潜望式镜头被用作“望远镜”,在苹果做之后,潜望式镜头或逐渐走向“一枚高倍长焦镜头”的定位,变得更加实用、常用。

如果不是在官网的细节注释中仔细查看,我们很难发现这枚5倍长焦镜头支持的最高变焦倍数为25倍。

除了对于镜头的定位,在硬件技术层面,苹果做的这枚长焦镜头,扒开来看,跟Android阵营的方案实则有很大不同。

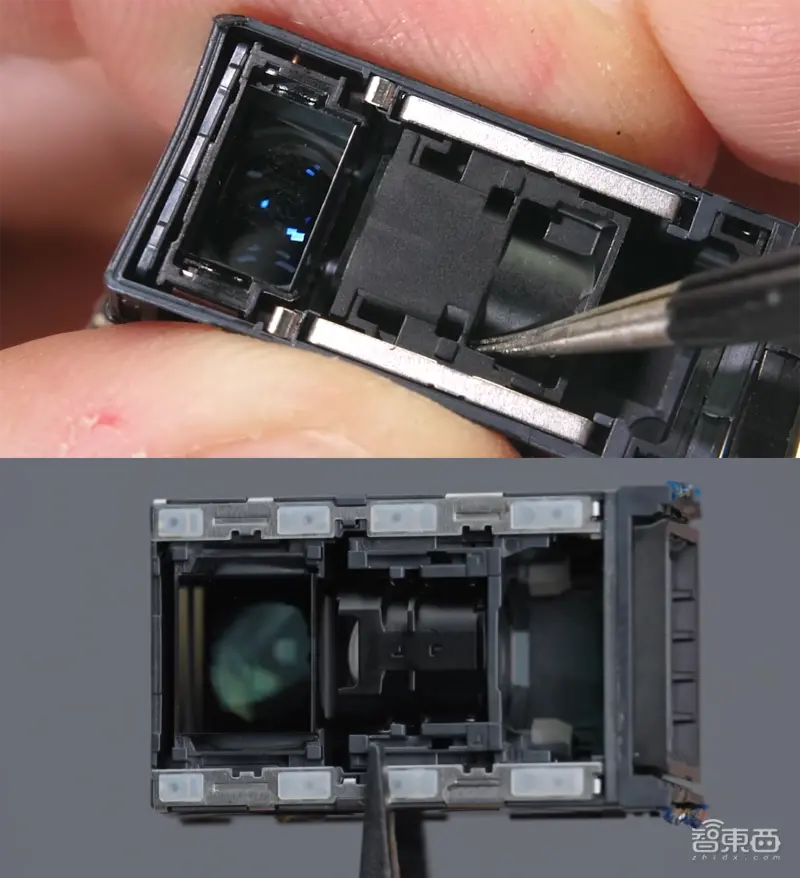

主要不同是两个:一个是这块四重反射棱镜,另一个是3D位移防抖。

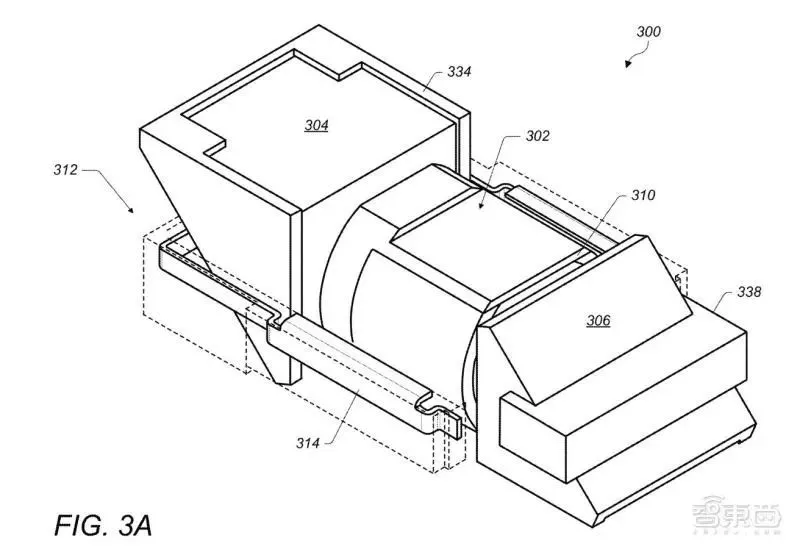

从苹果的拆解图来看,长焦内部只有一块棱镜,棱镜横截面为“平行四边形”,光线从一端进入,经过四次反射后垂直照射在CMOS图像传感器上。

反射越多次,就可以在有限空间内实现更长的光路,以实现更长的焦距。华为此前曾经通过三块棱镜的组合实现了五次光线反射,进而实现了10倍光学变焦。

与此前三星、OPPO、小米等多款手机潜望式镜头的拆解图对比来看,苹果这枚长焦镜头的结构比较特殊,光线经过的顺序是镜头、棱镜、传感器,而Android阵营潜望式镜头光线进入的顺序多为镜头、棱镜、镜组、传感器。

三星方案(上)与OPPO方案(下),来源:来源:JerryRigEverything、WekiHome

苹果这枚长焦的结构更为紧凑,棱镜与传感器之间并没有其他镜组。用一块棱镜实现四次反射,这在其他手机中暂时没有见到过。

同时,苹果这枚长焦的传感器是“平躺”在机身底部的,而Android阵营的传感器通常是竖直放置的。平放的好处包括传感器尺寸受到的限制会更小,这颗传感器的尺寸比iPhone 14 Pro Max的长焦更大。

同时,传感器平躺放置时,传感器及整个防抖对焦模组的运动空间也会更大,防抖效果也会更好。

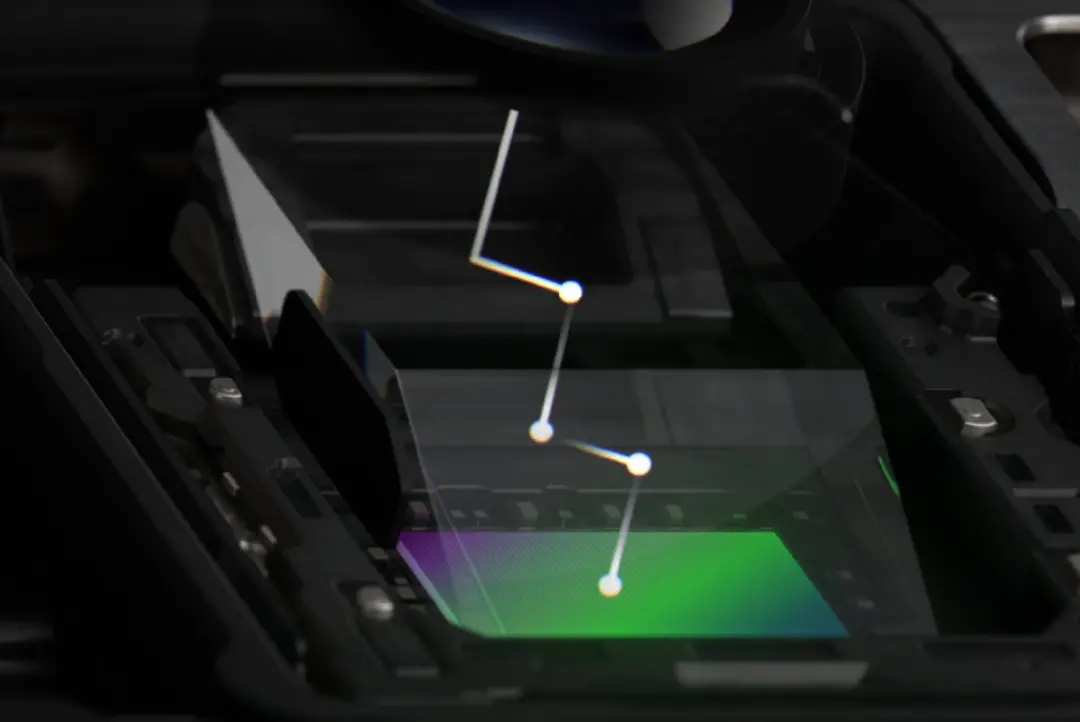

除了棱镜以及光路结构的特殊,苹果在这枚长焦镜头中使用了“3D传感器位移式光学图像防抖和自动对焦模块”,可以在X、Y、Z轴三个方向上进行位移,从而实现防抖。

苹果将这个方案称之为他们的“巅峰水准”,这个模块的微调频率为每秒10000次,是上一代的2倍。

这种防抖能力,在用户拍摄高倍数码变焦图像时,会通过“悬浮窗”功能体现,这一功能此前我们在三星手机上见过类似的,并不陌生了。

苹果的传感器位移防抖已经应用多年,但此前主要是在X、Y轴水平方向上移动,这次升级为“立体”防抖,并应用在5倍长焦中,在行业内并未看到先例。

在一些专业摄影人士看来,对于长焦拍照来说,尤其是120毫米及以上焦段,防抖是影像画质最关键的因素之一,因此苹果在防抖上的这一技术突破,对于保证最终成像效果是至关重要的。

除了稳定性,镜头进光量也是影响成片效果的关键因素之一。根据苹果官方说法,他们将这枚5倍长焦做到了行业内同焦段的最大光圈f/2.8,跟上代iPhone 14 Pro Max的3倍长焦相同,也就是说,苹果在增加等效焦距的基础上,并没有牺牲光圈尺寸。

数据来自各品牌官网

从目前各主流品牌旗舰机型潜望式长焦镜头的参数对比来看,苹果确实做到了。

从现有信息来看,苹果这枚长焦镜头的特殊设计,或许跟规避三星专利有一定关系。根据此前韩媒报道,苹果在潜望式镜头的开发过程中曾因三星专利问题而卡住,为了绕开三星专利,苹果曾“绞尽脑汁”,但最终解法并未公布。

这次靴子落地,苹果的方案从结构上来看显然跟三星、小米、OPPO等方案有很大区别,与此前曝光的相关专利,也不尽相同。

2023年8月苹果公布的潜望式镜头相关专利

也就是说,苹果很可能在这枚镜头中掌握了不少具有专利的独家技术。等后续有更多技术细节公布,我们或许可以对其有更深一步了解。

05.

性能提升“不够看”的A17 Pro,为何有着颠覆游戏产业的潜力?

说到A17 Pro这枚芯片,首先其命名可能就暗示了苹果后续的一些可能的规划。

例如规格略作“阉割”A17 Pro,是否会以“A17”的身份出现在下一代iPhone中?同一代不同结尾命名的A17芯片是否会用在iPad、iMac等平板、显示器、一体机产品中?

A17 Pro的改名,或许暗示了在当下这个节点,芯片一年一代的节奏或许要改变了。

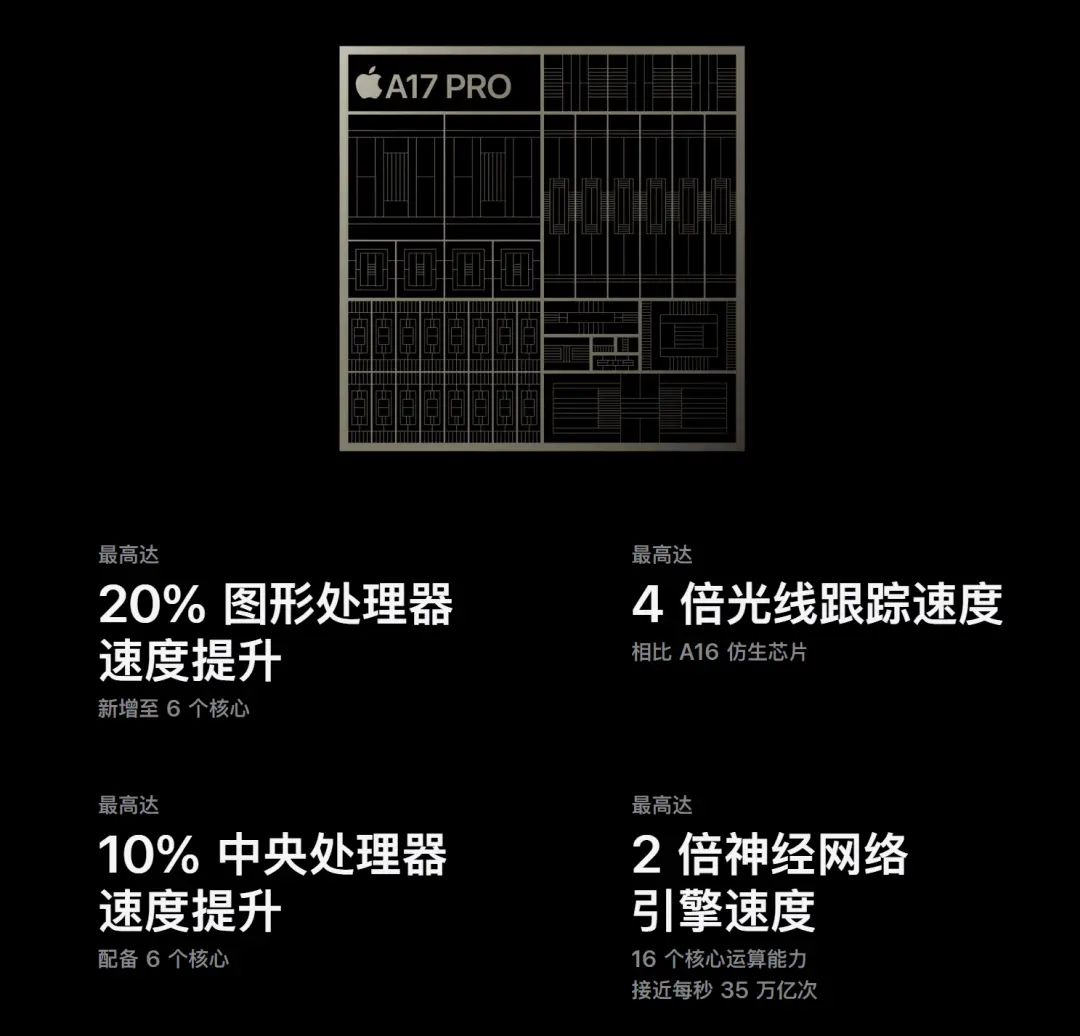

上代A16的晶体管数量为160亿个,A17 Pro的晶体管数量提升了18.7%,A17 Pro的CPU性能提升和GPU性能提升分别为10%和20%。

虽然我们不知道这些晶体管具体有多少分配给了CPU,多少分配给了GPU,但整体来看,A17 Pro性能提升的幅度是小于不少业内人士预期的,毕竟大家对于台积电3nm工艺给予了较高期望。

但从结果来看,到3nm阶段,芯片工艺制程带来的性能提升,确实已经不再像从前那样明显,例如从28nm迭代至14nm,从14nm迭代至7nm。

苹果A17 Pro中的3nm,其晶体管元件的宽度已经达到了12个硅原子级别。

或许这也是苹果这次对GPU架构进行“大改”的原因之一,但苹果这次并未透露A17 Pro具体CPU、GPU的IPC性能提升。

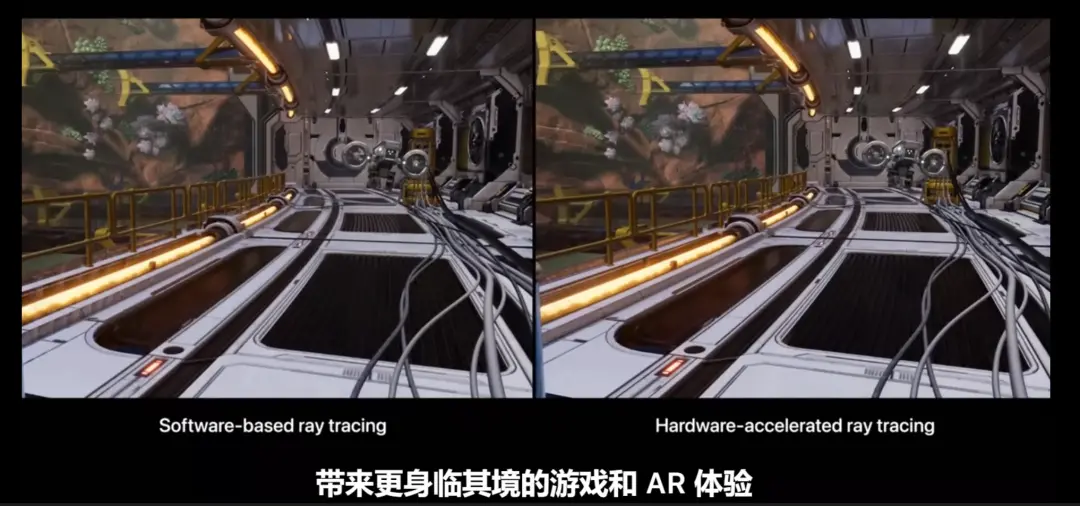

这次在GPU方面,苹果罕见的强调了其在游戏方面的一系列提升,其中光线追踪技术引起了不小的关注,而主机3A大作的原生落地,更是令不少人感叹,“你的下一台游戏主机,何必是主机?

此前高通和联发科都先于苹果发布了基于硬件的光线追踪技术,但目前能够落地让消费者感知到的游戏和应用还较为有限,这时苹果的生态号召力优势就凸显出来了。

在苹果生态开发应用的最大优势之一就是庞大的用户规模以及开发的便捷性,苹果几大移动设备之间的应用开发是一次开发多段部署的,同时,率先应用新技术并登录苹果的平台,也侧面对游戏厂商和开发者是有积极价值的。

这里不得不提到的就是iPhone开始原生适配各类主机、PC端的3A单机游戏作品,包括我们熟悉的《生化危机》系列、《刺客信条》系列。

苹果对于光追技术以及MetalFX、网格渲染等的引入,似乎在暗示着移动端游戏与主机端游在向着“融合打通”的方向发展,移动端游戏体验可以借助这些新技术,实现画质和体验的质变。

同时MetalFX等类似英伟达DLSS、AMD FSR这样的超采样技术,也一方面降低了移动端硬件处理的压力,让高画质与流畅度可以兼顾。

在iPhone上游玩《死亡搁浅》

对于目前的游戏产业来说,苹果的入局带动,很可能掀起移动端与主机PC端游戏的加速融合。

未来更多的知名游戏大作可能会在PC、主机以及手机端同步发售,这种体验对于许多玩家来说都是前所未有的。

当然,苹果现在确实“画了很多饼”,最终落地能否有宣传中的效果,这些新技术能否很好地应用到移动游戏中,我们还要到时候看具体“疗效”。

毕竟此前游戏对于苹果来说一直称不上是“强项”。

此外,苹果在介绍光追技术时提到的一句话也引起了我的注意,苹果称光追技术也可以带来更身临其境的AR体验,光追与苹果的头显又能如何结合?苹果这场发布会留下的问题,可能比回答的更多。

06.

数据跑在本地究竟意味着什么?苹果AI大招呼之欲出

在芯片部分,除了GPU,神经网络引擎部分的提升,也十分值得注意。

翻译过来,就是苹果在AI方面可能还是会有大动作。

A17 Pro中神经网络引擎35TOPS的算力,最直观的一个效果,就是让苹果的一些AI能力,可以本地化运行了,数据完全本地化处理,不用跑一遍云端。

相比之下,前阵子被车企们“众星捧月”般对待的高通第四代座舱芯片骁龙8295,其AI算力仅有30TOPS,苹果颇有些“杀鸡用牛刀”的意味。

本地化处理、数据的隐私安全保护,这些都是AI大模型落地时业内和消费者最为关心的问题之一。

不论是本地化的照片抠图,还是创建个性化语音,可以说苹果在AI方面做的一系列“基础设施建设”,可能都在为后续更多的产品和体验落地铺路。

《信息报》曾报道称,苹果自研大模型“Ajax GPT”的能力水平可能在GPT-3.5之上,参数量也超过了2000亿。

显然这样规模的大模型是不可能在iPhone端本地运行的,但苹果是否会像Google一样,优化出可以运行在移动设备上的版本?

这次在拍照方面,iPhone对于拍摄画面深度信息的自动捕捉和处理分析、自动开启人像模式、拍摄后对于照片不同被摄对象深度信息的灵活调整,都离不开背后AI算力、算法的支持。

在电影效果模式中,画面焦点的实时自动转换,一些特写镜头的精彩成片背后,AI也不可或缺。

当然,前文提到的iPhone在游戏端应用的超分、补帧等类似技术,在技术迭代的过程中也大概率会涉及到AI算法的应用。比如英伟达的DLSS 3以及DLSS 3.5,就应用了一系列AI技术来提升游戏帧率以及图像质量。

可以说,很多人都期待苹果在AI领域放出一些新大招,但实际上苹果对于AI的应用早已深入其软硬件生态各处。

07.

结语:颠覆式创新或许不必来的惊涛骇浪

梳理下来,苹果的这场春晚虽然表面上缺乏一些“噱头性”新功能,但实际在硬件、软件、算法、生态层面的一些细节改变都值得关注。

苹果仍然在做它最擅长的事:在不增加用户学习成本的前提下,将所有新功能体验打磨完善送到你面前,同时在底层悄悄实现N多技术突破,而这些突破中往往酝酿着产业变化的趋势和方向。

与其刷屏更多的“遥遥领先”,不如踏踏实实坐下来,看看两天市值跌去近6000亿元人民币仍能够维持全球市值第一的这家科技公司,到底事是怎么去做产品的。