139位中国天才,做出一家让硅谷震撼的公司

平替版Claude、和GPT-4“可以一战”、震撼硅谷的“国产之光”……2025年初,AI圈的首炸,属于脱胎于量化公司的DeepSeek。能用十分之一的价格、不到150人的研发团队,对打硅谷头牌大模型,DeepSeek的秘密何在?

当全球“AGI信仰”正因技术放缓遭遇挑战,“AI六小虎”的光芒开始褪色,沉寂的大模型领域急需一个振奋人心的新故事。

作为开年AI圈首炸,DeepSeek顶着“国产之光”的新王冠横空出世,震撼了海内外的一众科技大佬。

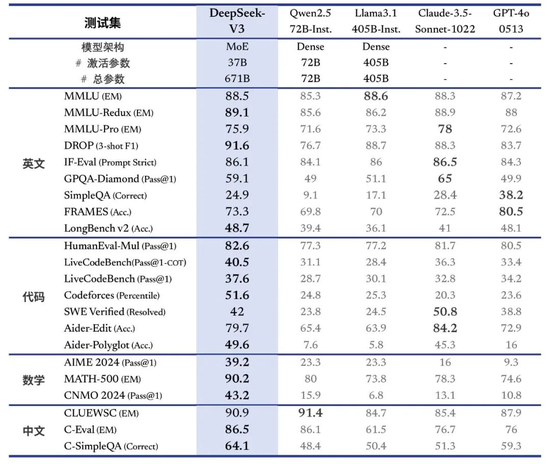

2024年12月,DeepSeek发布了最新的V3开源模型,评测成绩不仅超越了Qwen2.5-72B(阿里自研大模型)和Llama 3.1-405B(Meta自研大模型)等顶级开源模型,甚至能和GPT-4o、Claude 3.5-Sonnet(Anthropic自研大模型)等顶级闭源模型掰掰手腕。

更令人振奋的是,DeepSeek的故事很大程度上,打破了困扰国产大模型许久的算力芯片限制瓶颈。

V3模型是在2000块英伟达H800 GPU(针对中国市场的低配版 GPU)上训练完成的,而硅谷大厂模型训练普遍跑在几十万块更高性能的英伟达H100 GPU上。

这也让DeepSeek的训练成本得以被极大压缩。SemiAnalysis数据显示,OpenAI GPT-4训练成本高达6300万美元,而DeepSeek-V3成本只有其十分之一不到。

12月底,雷军开出千万年薪挖角DeepSeek研究员罗福莉的新闻,也让人们把更多目光投向了这个神秘团队。

据报道,DeepSeek包括创始人梁文锋在内,仅有139名工程师和研究人员。与之对比,OpenAI有1200名研究人员,Anthropic则有500多名研究人员。

2024年,这家鲜少做营销投放、创始团队极为低调的公司,还游离在主流视野之外。第一次引起普遍关注,还是因6个月前,DeepSeek首次掀起了大模型价格战,而被称作“AI界的拼多多”。

如今,没有寻求过外部融资、创始人有“囤卡富翁”之称、团队全是“清北等名校年轻人出品”——一串吸睛的标签,让这家AI创业圈的隐形巨头走向台前。

这一次,摆脱英伟达芯片束缚、技术平权的故事,轮到DeepSeek来讲了。

在硅谷“出圈”了

平替版Claude、和GPT-4“可以一战”、国产之光……2025年初的最大惊喜,属于脱胎于量化公司的DeepSeek。

相比于大模型公司的大手笔投流,或如Kimi、豆包等头部玩家还在用巨额营销换C端用户认知,DeepSeek的火热出圈,让故事有了“自上而下”的另一种讲法。

2024年12月底,DeepSeek V3大模型发布后便完全开源。模型测算数据显示,DeepSeek V3虽然文字生成类任务较弱,但其代码、逻辑推理和数学推理能力均名列前茅。

V3大模型上线后,DeepSeek同时上线了53页论文,将模型的关键技术与训练细节和盘托出。

论文披露:V3整个训练过程仅用了不到280万个GPU小时。相比之下,Llama 3 405B的训练时长是3080万GPU小时。考虑到V3训练芯片使用的是低配版的H800 GPU,其训练成本也被大幅缩减。这也动摇了行业内,“大模型能力跟芯片限制强绑定”的普遍认知。

OpenAI创始团队成员Andrej Karpathy发帖赞叹:DeepSeek-V3性能高过Llama3最强模型,且耗费资源仅十分之一,“未来或许不需要超大规模的GPU集群了”。

这也为长期受算力限制的创业团队们,提出了一个新解法——即便在算力有限的情况下,使用高质量数据、更好的算法,同样能训练出高性能大模型。

Meta科学家田渊栋惊叹道:“FP8预训练、MoE、预算非常有限的强大性能、从CoT中提取以进行引导……哇!这是伟大的工作!”

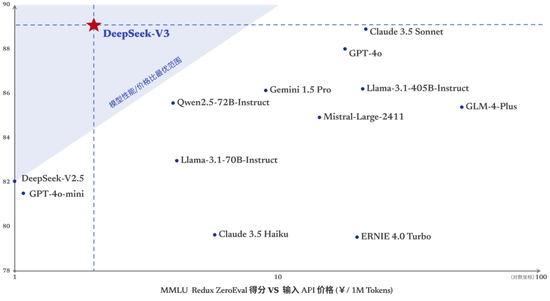

性能更强、速度更快的模型上线,也把DeepSeek的API调用定价进一步打了下来。近日,官方宣布DeepSeek的tokens价格调整为每百万输入tokens 0.5元(缓存命中)/2元(缓存未命中),每百万输出tokens 8元。

V3的发布,也引发了国内专业开发者社区的热烈讨论。不少AI应用层创业者、从业人士赞叹:“V3是用过的国产大模型里,编码能力最强的。”

有AI从业者在业务场景中应用后认为:“DeepSeek是目前国内唯一一个可以跟4o、Sonnet平起平坐的国产LLM(大语言模型)。”

能从系统角度,让模型越来越便宜,也给最近日趋焦灼的卷卡、卷算力、卷商业落地的大模型之战,提供了一种新的解法。

偏爱竞赛生,学院派管理

那么,能打造出如此低成本、高质量的模型,DeepSeek的团队又是怎样一群人?

实际上,早在DeepSeek出圈前,AI业界对它的技术实力评价便非常高。只是因为公司不融资,创始人鲜少露面,公司不做C端应用,以至于公众认知度偏弱。

从公开资料来看,DeepSeek团队最大的特点就是名校、年轻。有大模型领域的猎头告诉《财经天下》,当下“C9”院校的高端人才各家都在争抢。“DeepSeek更着重宣传,符合他们家年轻化,求知欲的价值观。”

即使是团队leader级别,年纪也多在35岁以下。该猎头表示,DeepSeek管理岗很少内部提升,大多挖的是有经验的,也会卡年龄。“我们这边推荐的几个leader岗,超过40岁没有特别大的优势,人家看都不愿意看。”

DeepSeek创始人梁文锋在接受36氪采访时,曾透露过招人标准:看能力,不看经验,核心技术岗位以应届和毕业一两年为主。

衡量年轻毕业生“优秀”与否的标准,除了院校,还有竞赛成绩,“基本金奖以下就不要了”。

DeepSeek也不偏好资深的技术人。例如,DeepSeekMath的三名核心作者,朱琪豪、邵智宏、Peiyi Wang,是在博士实习期间完成了相关的研究工作。V3研究成员代达劢,2024年才刚从北大获得博士学位。

在管理上,DeepSeek采取的是淡化职级、极为扁平的文化,将团队一直控制在150人左右的规模。用粗暴砸钱、给卡,相当扁平和“学院派”的管理方式,挽留人才。

梁文锋将这种组织形式形容为“自下而上”“自然分工”:“每个人有自己独特的成长经历,都是自带想法的,不需要push他……当一个idea显示出潜力,我们也会自上而下地去调配资源。”

“只招1%的天才,去做99%中国公司做不到的事情。”曾经面试过DeepSeek的应届生如此评价其招聘风格。

这种人才选择和管理模式,某种程度上很像OpenAI。二者都更像是纯粹的研究机构——早期不融资,不做应用,不考虑商业化。

在当下AI大模型市场渐趋饱和之下,DeepSeek也因不争抢排名座次,不造舆论声势,重用应届生,专注做底层技术优化,成为了国内为数不多还在招揽有“AGI信仰”人才的公司。

实际上,从DeepSeek创立之初,它的履历便像个行业“异类”。

2023年,DeepSeek的AI产品正式对外亮相。此前数年,该公司曾对该产品内部“孵化”许久,并对外招聘过文科人才,职位定位为“数据百晓生”,提供历史、文化、科学等相关知识来源。

DeepSeek的母公司是梁文锋在2015年创立、量化基金起家的幻方量化。作为一个“80后”,梁文锋本科、研究生都就读于浙江大学,拥有信息与电子工程学系本科和硕士学位。

幻方量化也是头部量化基金中的“例外”:多数量化基金创始班底,都或多或少有海外对冲基金的履历。唯独幻方完全靠本土班底起家,独自摸索着长大——这跟DeepSeek 的用人风格也极其相似。

2017年,幻方量化宣称实现投资策略全面AI化。2019年,其资金管理规模超100亿,成为国内量化私募“四巨头”之一,也一度是国内首家突破千亿私募的量化大厂。

当幻方量化规模节节攀升时,梁文锋却开始转移视野。

在业界,幻方一直以敢于在硬件上投入著称,以支撑其交易系统的实施。2017年前后,梁文锋开始涉足AI相关探索,探索孵化AI项目“萤火虫”。2018年,“萤火虫”超级计算机对外正式亮相,并称计算机占地面积为数个篮球场,前后投入超过10亿元。

2021年,在梁文锋参与的论文中提到,他们正在部署的萤火二号系统,“配备了1万张A100GPU芯片”,在性能上接近DGX-A100(英伟达推出的人工智能专用超级计算机),但成本降低了一半,同时能耗减少了40%——业界通常认为,1万枚英伟达A100芯片是做自训大模型的算力门槛,当时国内超过1万枚GPU的企业不超过5家。

GPU芯片的丰厚储备,也为幻方量化接下来的转型提供了基础。

2023年5月,梁文锋实控的AI研发机构北京“深度求索”成立,次年DeepSeek正式上线。从这时起,幻方量化也开始主动缩减资金规模,不再参与量化基金第一梯队的竞争。

2024年10月,幻方量化向投资者公告称,计划逐步将对冲产品投资仓位降低至零。该公司部分对冲系列产品规模已经降至千万元以下。至2025年初,公司资金管理规模已小于300亿,退出了行业前六名。

最像OpenAI的中国公司

从量化基金转型后,能在短时间内冲上AI头部玩家,DeepSeek的“神奇”技术在其53页的论文中,也并不是秘密。

界面新闻报道,V3模型主要采用了模型压缩、专家并行训练、FP8混合精度训练等一系列创新技术降低成本。作为新兴的低精度训练方法,FP8技术通过减少数据表示所需的位数,显著降低了内存占用和计算需求。目前,零一万物、谷歌、Inflection AI都已将这种技术引入模型训练与推理中。

此外,在预训练阶段,对性能影响有限的地方,DeepSeek选择了极致压缩。而在后训练阶段,对模型擅长的领域,他们又倾注全力提升。

核心人才也带来了关键的技术创新。量子位报道,2024年5月发布的DeepSeek-V2中,其创造性地提出了一种“新型注意力”,在Transformer架构的基础上,用MLA(Multi-head Latent Attention)替代了传统的多头注意力,大幅减少了计算量和推理显存。

其中,高华佐和曾旺丁为MLA架构做出了关键创新。高华佐目前只知道是北大物理系毕业,这个名字在“大模型六小虎”之一的阶跃星辰专利信息中,也可以看到。

DeepSeek-V2还涉及了另一项关键成果——GRPO。这是PPO的一种变体RL算法,显著减少了训练资源的需求。在开源大模型阿里Qwen 2.5的技术报告中,GRPO技术也有所体现。

这些技术创新,也为当下有些“困窘”的国内大模型未来发展,提供了一种新的解题思路。

特别是2024年下半年,长文本市场竞争已在字节的“饱和式攻击”下逐渐尘埃落定。AI圈中出现了一种无奈共识:在大厂射程范围内,做类ChatGPT产品已经没有机会,必须要做出差异化。

大模型竞赛也进入了下一段更艰巨的赛程,成为了一场拼资源的“战争”,要拼资金、人才密度、数据算力能力。

去年还风光无限的“大模型六小虎”正在加速寻找垂类场景商业化机会。近期,MiniMax转战文生视频,宣布要跟Sora掰手腕;智谱则瞄准智能体(Agent)市场,从做智能体商店到邀测PC端智能体;百川智能逐渐专注于医疗市场;零一万物则宣布深耕零售营销业务,不再追求AGI。

而DeepSeek能够奇袭,很大程度上源于和头部大模型公司保持距离,远离融资的热闹和商业化的压力。

在梁文锋为数不多的发声中,他表示DeepSeek创立初期,就在接触投资圈后清醒认识到,“很多VC对做研究有顾虑,他们有退出需求,希望尽快做出产品商业化。而按照我们优先做研究的思路,很难从VC那里获得融资”。

他也对外表达过“短期内没有融资计划”,并认为当下面临的问题“从来不是钱,而是高端芯片(短缺)”。

梁文锋也明确提出,硅谷对DeepSeek“惊叹”的原因——“因为这是一个中国公司,在以创新贡献者的身份,加入到他们游戏里去。毕竟大部分中国公司习惯follow,而不是创新。”

“中国也要逐步成为贡献者,而不是一直搭便车。”梁文峰说。“我们已经习惯摩尔定律从天而降,躺在家里18个月就会出来更好的硬件和软件,Scaling Law(规模定律)也在被如此对待。但其实,这是西方主导的技术社区一代代孜孜不倦创造出来的,只因为之前我们没有参与这个过程,以至于忽视了它的存在。”

梁文锋认为,中国AI的发展,同样需要这样的生态。“很多国产芯片发展不起来,也是因为缺乏配套的技术社区,只有第二手消息,中国必然需要有人站到技术的前沿。”

作者 | 赵小天

热门评论

>>共有0条评论,显示0条