Anthropic为更危险的人工智能领域制定了新规则

为应对日益增长的安全担忧,Anthropic 更新了其 Claude AI 聊天机器人的使用政策。除了引入更严格的网络安全规则外,Anthropic 还明确规定了禁止人们使用 Claude 进行开发一些最危险的武器。

Anthropic在总结其变化的文章中并未重点介绍其武器政策的调整,但将公司新旧使用政策进行比较,可以发现显著差异。尽管 Anthropic 此前禁止使用 Claude“生产、改装、设计、销售或分发旨在造成人员伤亡的武器、爆炸物、危险材料或其他系统”,但新版政策在此基础上进行了扩展,明确禁止研发高当量爆炸物以及生物、核武器、化学和放射性 (CBRN) 武器。

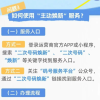

今年5月,Anthropic公司在其新款Claude Opus 4模型发布的同时,实施了“AI安全等级3”保护措施。这些保护措施旨在提高该模型的越狱难度,并防止其协助开发CBRN武器。

Anthropic 在其文章中也承认了代理型人工智能工具带来的风险,包括允许 Claude 控制用户计算机的“Computer Use”,以及将 Claude 直接嵌入开发者终端的工具“Claude Code”。Anthropic 写道:“这些强大的功能带来了新的风险,包括大规模滥用、恶意软件创建和网络攻击的可能性。”

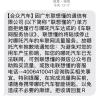

为了应对这些潜在风险,这家人工智能初创公司在其使用政策中新增了“不得危害计算机或网络系统”部分。该部分规定禁止使用 Claude 发现或利用漏洞、创建或分发恶意软件、开发拒绝服务攻击工具等。

此外,Anthropic 正在放宽其政治内容政策。Anthropic 不再禁止创建所有与政治竞选和游说相关的内容,而是仅禁止用户将 Claude 用于“欺骗或破坏民主进程,或涉及选民和竞选活动的用例”。该公司还澄清说,其对所有“高风险”用例(即用户使用 Claude 向个人或客户提供推荐时)的要求仅适用于面向消费者的场景,不适用于商业用途。