华为自研HBM内存正式公布:最大144GB 带宽4TB/s

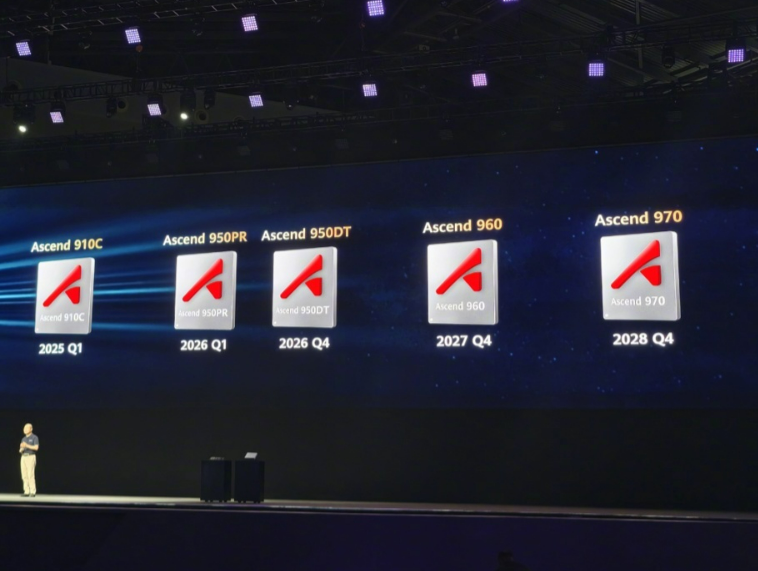

今日举办的华为全联接大会2025上,华为轮值董事长徐直军首次公布了昇腾芯片演进和目标。他表示,未来三年,华为已经规划了昇腾多款芯片,包括昇腾950PR、950DT以及昇腾960、970。其中昇腾950PR 2026年第一季度对外推出,该芯片采用了华为自研HBM。

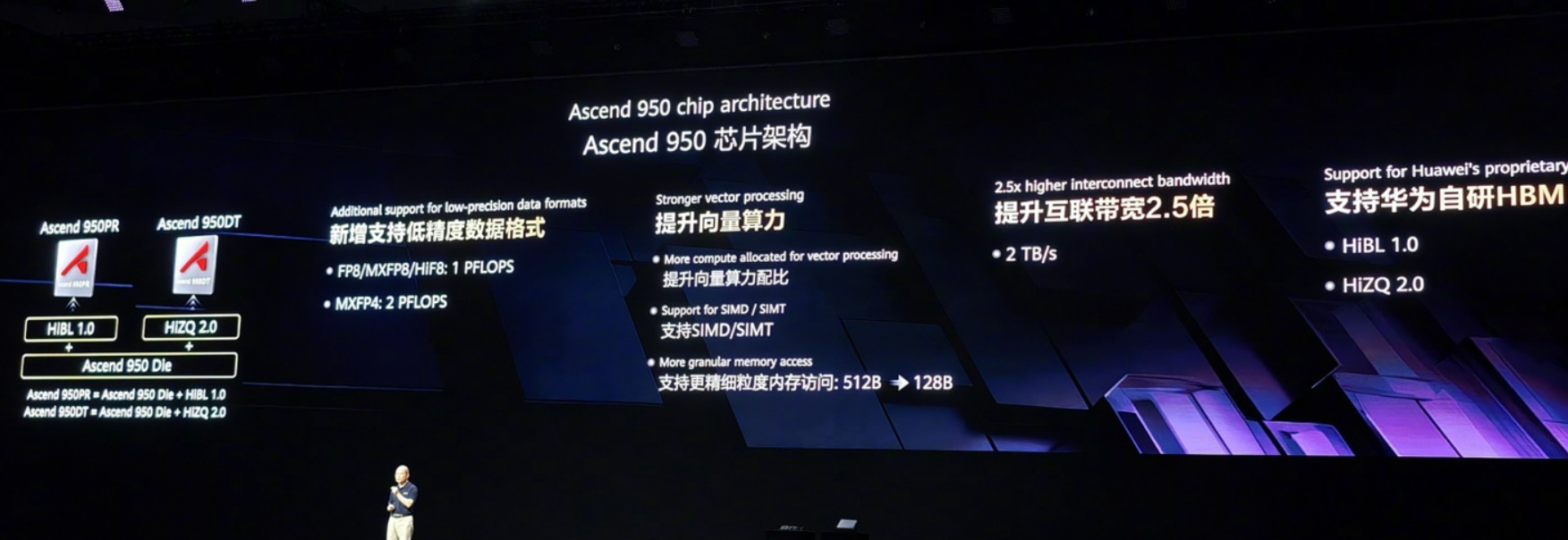

根据现场公布的信息,昇腾950PR芯片架构新增支持低精度数据格式,其中FP8/MXFP8/HIF8: 1 PFLOPS,MXFP4: 2 PFLOPS,重点提升向量算力,提升互联宽带2.5倍,支持华为自研HBM高带宽内存,分为HiBL 1.0和HiZQ 2.0两个版本。

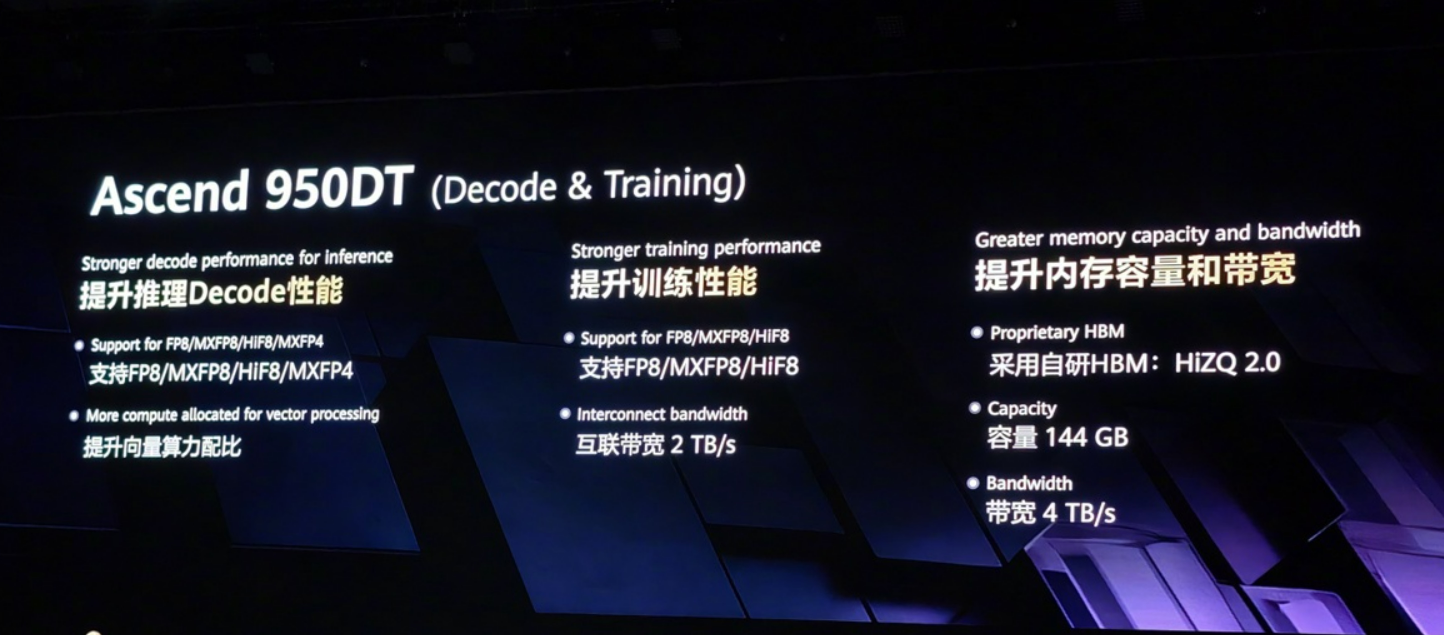

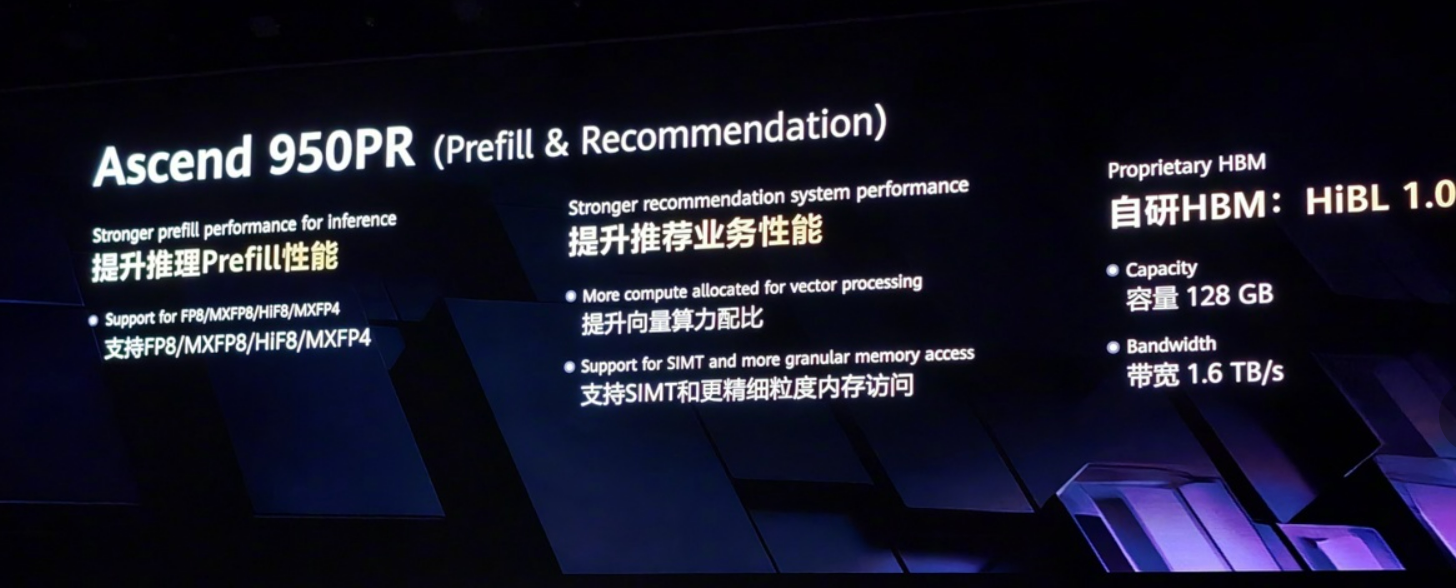

规格方面,HiBL 1.0容量128GB,带宽1.6TB/s;HiZQ 2.0容量144GB,带宽4TB/s。

其中,昇腾950PR芯片采用950核心+HiBL 1.0内存,可提升推理Prefill(预填充)性能,提升推荐业务性能。

昇腾950DT采用HiZQ 2.0内存,可提升推理Decode(解码)性能,提升训练性能,提升内存容量和带宽。

延伸阅读:

在大模型推理中,Prefill阶段负责接收完整输入数据(如文本或图像),并计算缓存。这一过程需要强大的算力支持,通常由高性能芯片完成。 该阶段强调算力而非内存带宽,因此更适合在HBM(高带宽内存)芯片上运行。相比之下,后续的Decode阶段更依赖高速内存传输和互联方案。

HBM(High Bandwidth Memory,高带宽内存)是一种基于3D堆叠技术的先进DRAM解决方案,多层DRAM芯片垂直集成,显著提升数据传输效率。具有超高带宽与低延迟、高容量密度、高能效比等优势,能协助快速处理数据密集型的AI任务。

美国国际战略研究中心(CSIS)AI专家艾伦(Gregory Allen)解释,HBM对于制造先进AI芯片至关重要,价值约占整体芯片的一半。

AI推理需频繁调用海量模型参数(如千亿级权重)和实时输入数据。HBM的高带宽和大容量允许GPU直接访问完整模型,可避免传统DDR内存因带宽不足导致的算力闲置。对于千亿参数以上的大模型,HBM可显著提升响应速度。

当下,HBM已成为高端AI芯片的标配,训练侧渗透率接近100%,推理侧随模型复杂化加速普及。