阿里又一大模型开源 手机电脑样样玩的溜 多项测试秒GPT-5

今天,阿里通义大模型团队宣布推出全新升级的Qwen3-VL系列模型,并宣布旗舰版本Qwen3-VL-235B-A22B系列开源。这是Qwen系列中最强的视觉语言模型。Qwen3-VL的目标,是让模型不仅能看到图像或视频,更能真正看懂世界、理解事件、做出行动。

在官方演示中,Qwen3-VL已经展现出强大的视觉驱动推理与执行能力,可操作手机、电脑等设备。模型可以根据自然语言指令打开应用、点击按钮、填写信息等,帮你轻松完成航班的查询和预定。

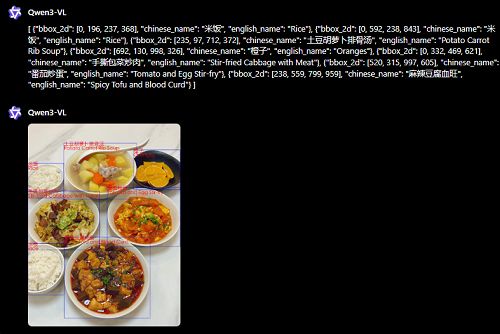

Qwen3-VL也具备识别万物的能力,名人、美食、动植物、汽车品牌、动漫角色等均在其知识储备范围内。上传一张图片,模型就能准确报菜名,还是带定位框的那种。

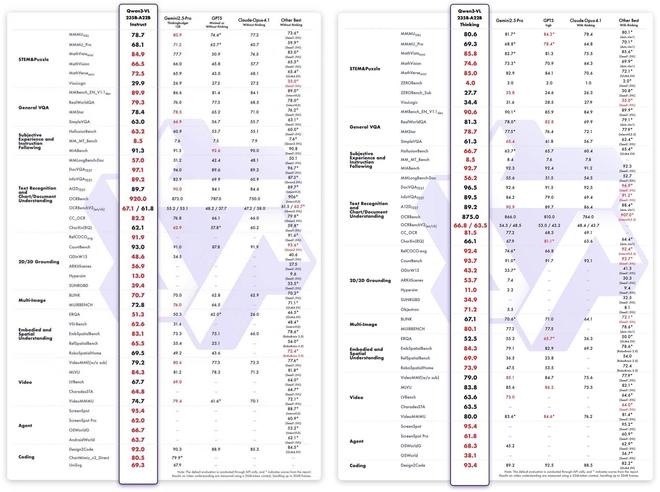

在十个维度的全面评估中,Qwen3-VL-235B-A22B-Instruct在非推理类模型中,多数指标表现最优,超越了Gemini 2.5 Pro和GPT-5等闭源模型,同时刷新了开源多模态模型的最佳成绩,在复杂视觉任务上具备强大泛化能力与综合性能。

而在推理模型方面,Qwen3-VL-235B-A22B-Thinking同样在多数指标上创下开源多模态模型的新高,与Gemini 2.5 Pro和GPT-5等闭源顶尖模型相比各有胜负。虽然在多学科问题、视觉推理和视频理解方面与闭源SOTA模型仍存在一定差距,但在Agent能力、文档理解、2D/3D Grounding等任务上展现出明显优势。

▲左侧为Qwen3-VL-235B-A22B-Instruct等非推理模型得分,右侧为Qwen3-VL-235B-A22B-Thinking等推理模型得分

目前,Qwen3-VL-235B-A22B-Instruct、Qwen3-VL-235B-A22B-Thinking均已开源至Github、Hugging Face、魔搭等开源平台,用户也可在Qwen Chat里直接体验模型表现。

开源地址:

https://modelscope.cn/collections/Qwen3-VL-5c7a94c8cb144b

https://huggingface.co/collections/Qwen/qwen3-vl-68d2a7c1b8a8afce4ebd2dbe

https://github.com/QwenLM/Qwen3-VL

体验链接:

https://chat.qwen.ai

一、八大能力效果惊艳,看截图用600行代码再造小红书

在博客中,阿里通义大模型团队介绍了Qwen3-VL系列模型的八大能力。

视觉智能体

Qwen3-VL能操作电脑和手机界面、识别GUI元素、理解按钮功能、调用工具、执行任务,在OS World等基准测试上达到世界顶尖水平,能通过调用工具有效提升在细粒度感知任务的表现。

官方Demo中,Qwen3-VL能在电脑中快速完成复制粘贴工作,还能把文件保存为Word文档。或是根据用户指令,输出航班出发地、到达地、时间等信息,帮用户节省繁琐的操作流程。

文本能力

Qwen3-VL在预训练早期即混合文本与视觉模态协同训练,在纯文本任务上表现与Qwen3-235B-A22B-2507纯文本旗舰模型不相上下。结合视觉能力后,它能根据图片或视频内容生成生动的文字描述,适用于故事创作、文案撰写、短视频脚本等创意场景。

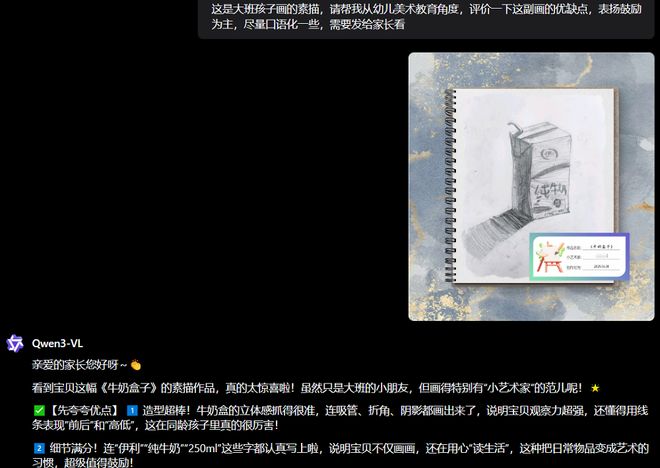

官方Demo展现了一个非常实用的Case,可以直接把孩子的素描作业发给Qwen3-VL,模型能根据画面内容和用户提示词,给出准确的评价。

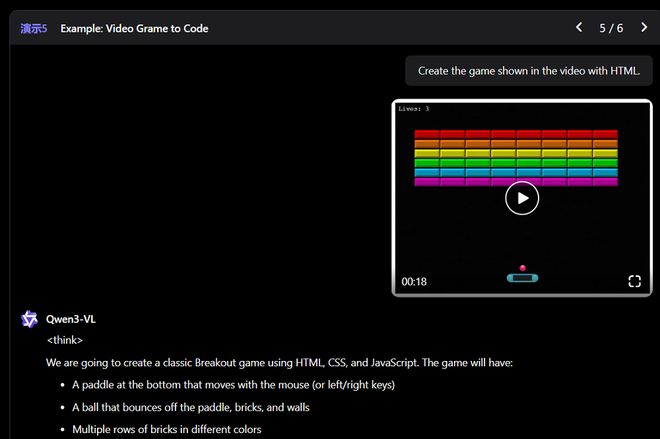

视觉Coding能力

Qwen3-VL能实现图像生成代码以及视频生成代码,例如看到设计图,代码生成Draw.io/HTML/CSS/JS代码,真正实现“所见即所得”的视觉编程。

智东西将一张小红书网页版的截图上传给Qwen3-VL,不过,首先遇到的是其安全机制。模型认为直接复制小红书的设计有侵权风险,多次拒绝此类任务。

随后,我们向模型保证了相关代码仅用于展示,模型这才同意上手开发。最终,Qwen3-VL用600多行代码实现了复刻,除了未能显示图片之外,网页基本实现了90%的还原度。

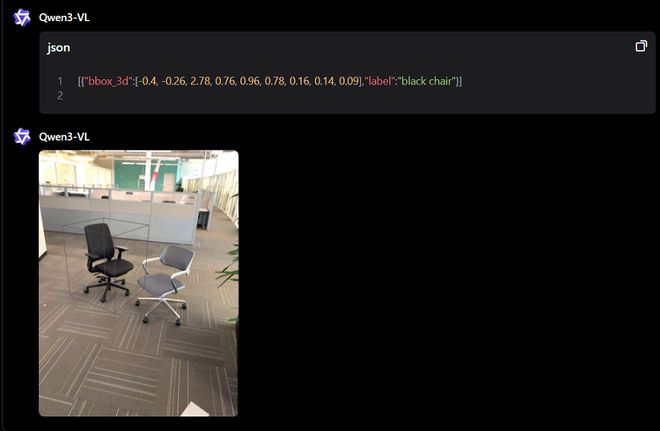

空间感知能力

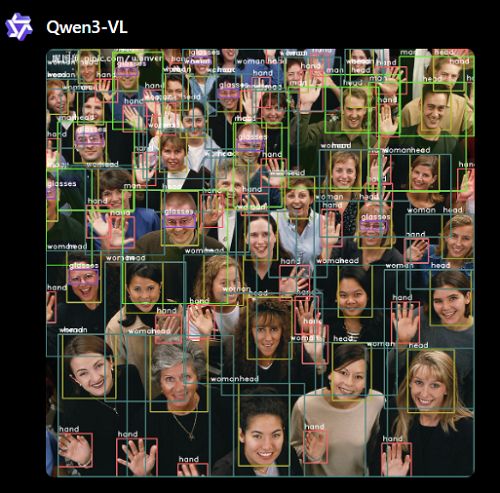

Qwen3-VL在2D grounding任务上从绝对坐标变为相对坐标,支持判断物体方位、视角变化、遮挡关系。

它也同时支持直接预测3D边界框,还原物体在真实世界中的位置和大小。

长上下文支持和长视频理解

Qwen3-VL全系列模型原生支持256K tokens的上下文长度,并可扩展至1M token。这意味着,无论是几百页的技术文档、整本教材,还是长达两小时的视频,都能完整输入、全程记忆、精准检索。视频定位可精确到秒级别时刻。

例如,在256K tokens上下文的“视频大海捞针”实验中,Qwen3-VL的准确率达到100%;当上下文扩展至1M tokens时,对应视频时长约2小时,准确率仍保持在99.5%。

在官方Demo中,模型能看懂一条20多分钟的外语视频,并据此整理出一道菜谱。

甚至可以通过观看游戏视频自动生成对应的游戏代码。

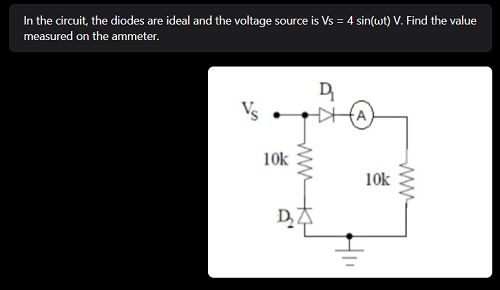

多模态思考能力

Qwen3-VL系列的Thinking模型重点优化了STEM与数学推理能力。面对专业学科问题,模型能捕捉细节、抽丝剥茧、分析因果、给出有逻辑、有依据的答案,在MathVision、MMMU、MathVista等权威评测中达到领先水平。

智东西直接将官方Demo中的一则案例截图,考察模型能否正确解答。

模型准确地识别了图中的文字和画面,思考2-3分钟后,给出了正确答案。

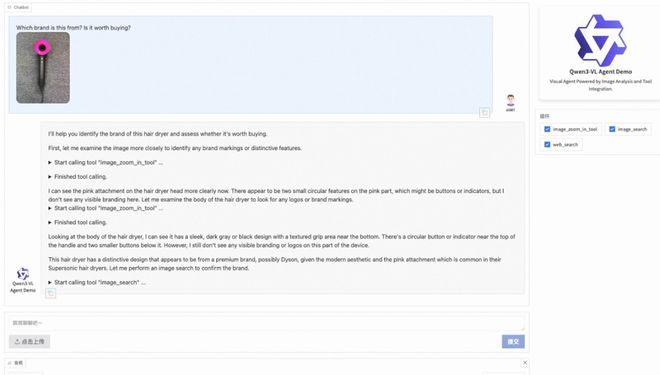

视觉感知与识别能力

通过优化预训练数据的质量和广度,Qwen3-VL现在能识别更丰富的对象类别——从名人、动漫角色、商品、地标,到动植物等,覆盖日常生活与专业领域的“万物识别”需求。

官方Demo中,仅需上传一张吹风机的图片,模型就能主动进行图像感知,并调用搜索工具,给出品牌等信息,并提供是否值得购买的建议。

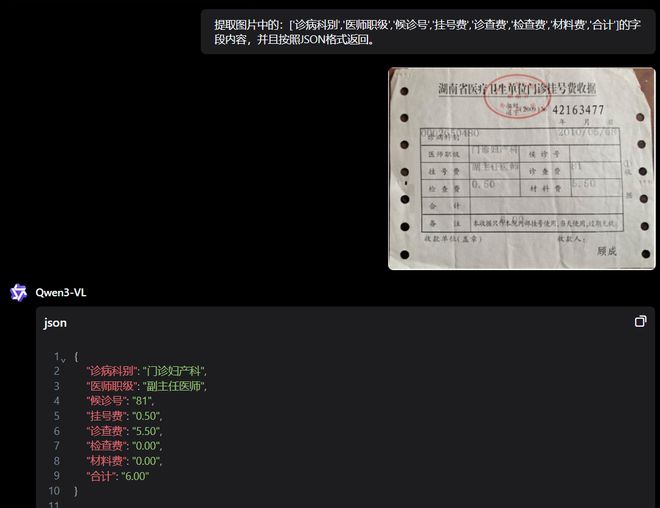

OCR支持更多语言及复杂场景

在复杂光线、模糊、倾斜等实拍挑战性场景下,Qwen3-VL的表现更稳定;对生僻字、古籍字、专业术语的识别准确率也有提升;超长文档理解和精细结构还原能力进一步提升。

例如,官方Demo中,这张实拍的挂号费收据字迹模糊,还有重叠,肉眼看着都有些费劲。但模型能准确识别字样,并根据指定格式输出。

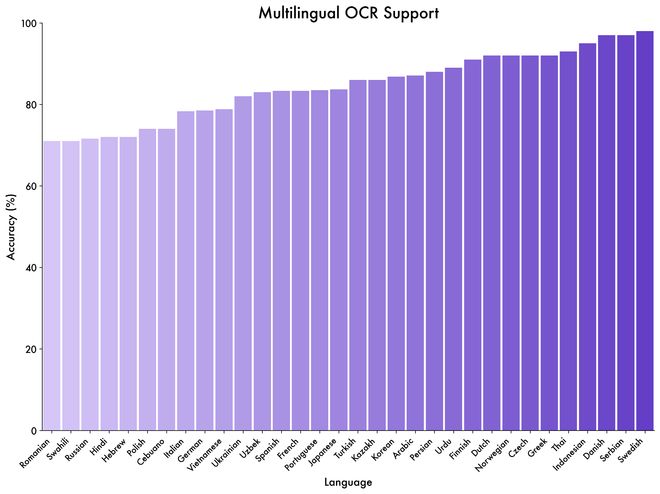

Qwen3-VL能识别的非中文、英文语言从10种扩展到32种,覆盖更多国家和地区。在这32种语言上,模型的识别准确率已经超过70%,达到实际可用水平。这些语言包括瑞典语等欧洲语言、斯瓦西里语等非洲语言、越南语等东南亚语言、印地语和乌尔都语等南亚语言和日语韩语等东亚语言,基本覆盖了常用的小语种。

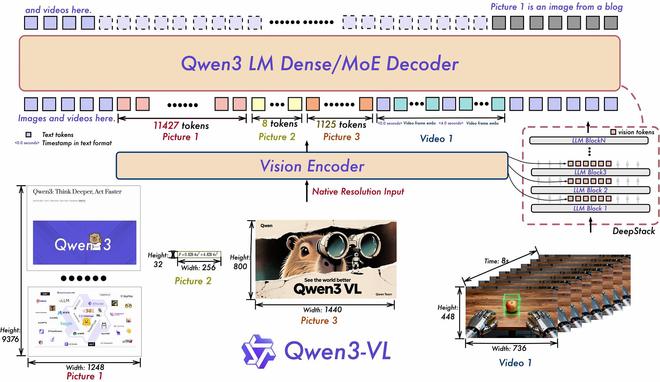

二、采用原生动态分辨率设计,结构迎来三大更新

在模型架构上,Qwen3-VL仍旧采用原生动态分辨率设计,但在结构设计上进行了更新:

一是采用MRoPE-Interleave,原始MRoPE将特征维度按照时间(t)、高度(h)和宽度(w)的顺序分块划分,使得时间信息全部分布在高频维度上。

Qwen3-VL中采取了t,h,w交错分布的形式,实现对时间,高度和宽度的全频率覆盖,这样更加鲁棒的位置编码能够保证模型在图片理解能力相当的情况下,提升对长视频的理解能力。

二是引入DeepStack技术,融合ViT多层次特征,提升视觉细节捕捉能力和图文对齐精度。阿里通义大模型团队沿用DeepStack的核心思想,将以往多模态大模型单层输入视觉tokens的范式,改为在大语言模型的多层中进行注入。这种多层注入方式旨在实现更精细化的视觉理解。

在此基础上,阿里通义大模型团队进一步优化了视觉特征token化的策略。具体而言,Qwen3-VL将来自ViT不同层的视觉特征进行token化,并以此作为视觉输入。这种设计能够有效保留从底层(low-level)到高层(high-level)的丰富视觉信息。实验结果表明,该方法在多种视觉理解任务上均展现出显著的性能提升。

三是将原有的视频时序建模机制T-RoPE升级为文本时间戳对齐机制。该机采用“时间戳-视频帧”交错的输入形式,实现帧级别的时间信息与视觉内容的细粒度对齐。

同时,模型原生支持“秒数”与“时:分:秒”(HMS)两种时间输出格式。这一改进提升了模型对视频中动作、事件的语义感知与时间定位精度,使其在复杂时序推理任务——如事件定位、动作边界检测、跨模态时间问答等——中表现更稳健、响应更精准。

结语:从多模态到智能体,VL模型展现庞大想象空间

生成式AI与真实世界场景的结合越来越密切,在文本模态之外,图像、视频等多模态任务,也正在成为AI落地的关键场景之一。

未来,VL模型的潜力不仅在于识别物体、理解文档或解析视频,更在于成为驱动Agent的大脑。它们将具备跨模态感知、跨任务推理、跨场景执行的能力,从个人助手到工业自动化、从教育科研到医疗健康,均有望释放出巨大价值。

热门评论

>>共有0条评论,显示0条