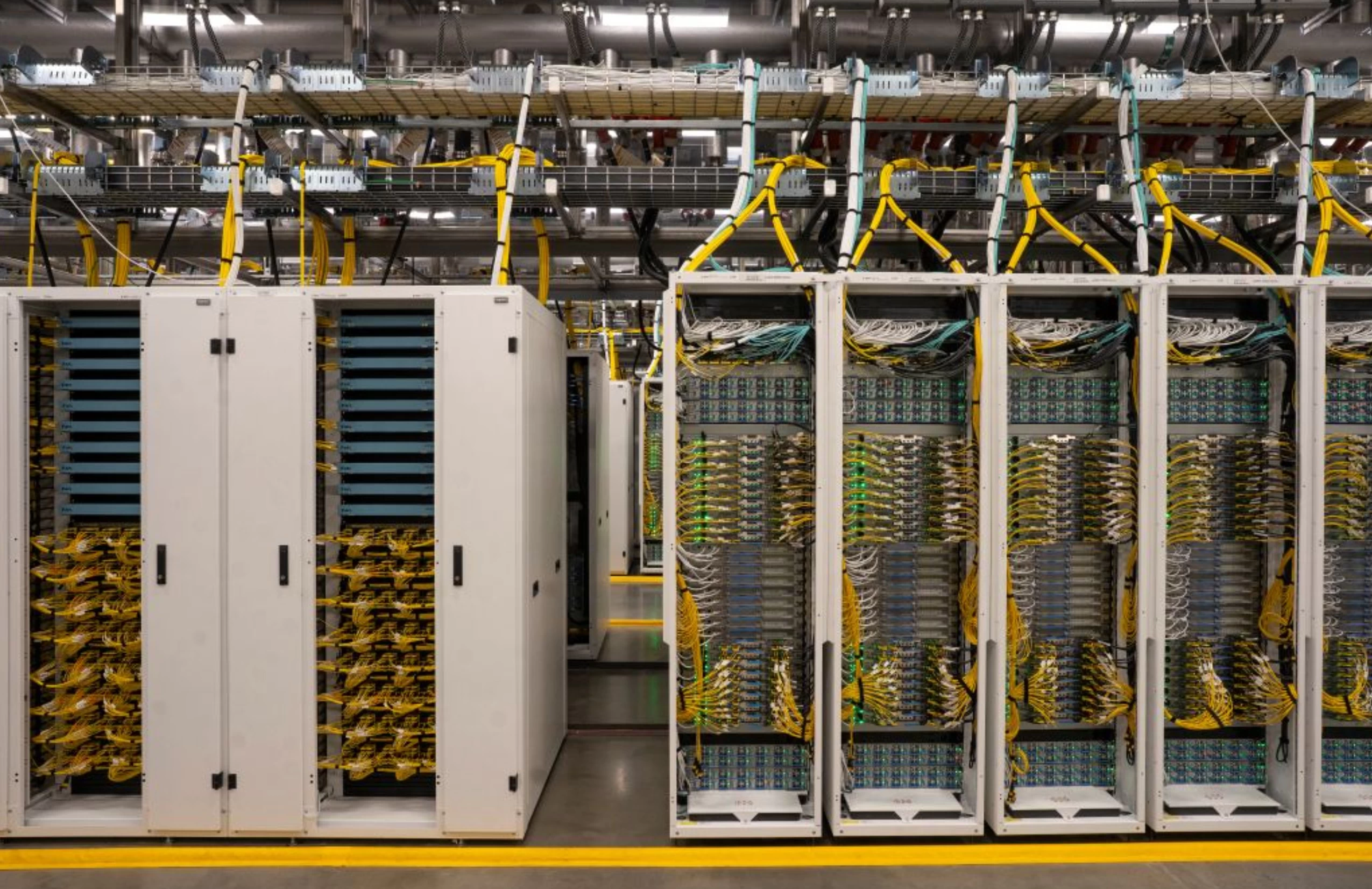

微软揭示新一代Azure AI超级数据中心的架构

微软今日宣布将在美国佐治亚州亚特兰大建立新的Fairwater Azure AI数据中心。这一新址将通过连接现有的威斯康星州Fairwater数据中心以及现有的Azure AI超级计算机,构建一个面向全球、可运行多种AI工作负载的超大规模AI数据中心。

微软表示,公司在满足OpenAI等人工智能训练需求的过程中积累了丰富经验,并据此彻底重构了AI数据中心设计理念。这款全新的AI数据中心采用了单层扁平网络架构,能够整合数十万颗NVIDIA GB200以及GB300系列GPU的算力,实现超大规模AI计算需求。

微软重点介绍了新一代数据中心较以往的主要创新:

极高的GPU密度:采用定制机架高密度部署NVIDIA Blackwell/GB系列GPU,高效降低延迟并提升GPU间通讯效率。

闭环液体冷却:密封式冷却系统能够循环使用同一批水资源超过六年,几乎零蒸发,保障高密度算力的可持续运行。

超大功率供给:每组机架140千瓦,每排达到约1.36兆瓦,轻松应对次世代加速器的高能耗,无传统电力瓶颈。

扁平化、高带宽网络:双层以太网架构,单GPU连接速率可达800Gbps,基于SONiC的网络设计降低成本、复杂度,并减少对单一供应商的依赖。

应用感知型网络优化:实时数据包裁剪、数据包喷洒和高级负载均衡技术,确保超大GPU集群高效利用率。

全球规模AI广域网:如亚特兰大与威斯康星等多个站点通过专用、低延迟光学骨干相连,形成跨区域统一“超级计算机”。

高韧性电网优化供电:充分利用当地强大的公用电网,实现高可用性,并以能量存储缓冲应对工作负载功率波动。

兼容所有AI工作负载:预训练、微调、强化学习、推理以及合成数据生成可在同一基础架构高效运作。

通过打造统一的多区域超级计算平台,微软正积极布局,满足未来数年AI工作负载呈指数级增长的需求。