今天凌晨2点,OpenAI进行了技术直播,对GPT-4o和Sora进行了重大更新,提供了全新文生图模型。除了文生图之外,该模型还支持自定义操作、连续发问、风格转换、图像PPT等超实用功能,例如,更改图片的宽高比、图像物体中的角度,用十六进制代码指定精确颜色等。

尤其是生成图像的逼真度,肉眼几乎看不出任何破绽,在精细度、细节和文本遵循方面非常出色,可以媲美甚至在某些功能超过该领域的头部平台Midjourney。

新图像模型功能展示

话不多说,“AIGC开放社区”就用免费版为大家展示一下实际的生成案例。

我们先测试一下模型的文本还原和细节表现,来个复杂点的提示词

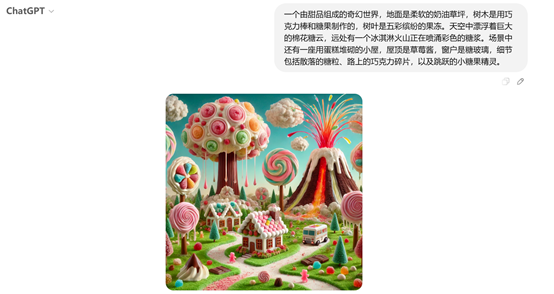

提示词:一个由甜品组成的奇幻世界,地面是柔软的奶油草坪,树木是用巧克力棒和糖果制作的,树叶是五彩缤纷的果冻。天空中漂浮着巨大的棉花糖云,远处有一个冰淇淋火山正在喷涌彩色的糖浆。

场景中还有一座用蛋糕堆砌的小屋,屋顶是草莓酱,窗户是糖玻璃,细节包括散落的糖粒、路上的巧克力碎片,以及跳跃的小糖果精灵。

构图、文本还原能力非常棒!一次就完成,生成时间大约在15秒左右。

再试一下它的新功能,其实OpenAI官方说这是一个“世界知识”功能,但是使用之后感觉更像是一个图像PPT功能,对于教育、金融、医疗等领域帮助非常大。

例如,帮我用图像介绍牛顿第一定律。就能直接生成详细介绍牛顿定律的图像,感觉和PPT差不多吧。

提示词:用一张图片介绍人体各个结构。

这个人体介绍图片就丰满很多,放在医疗介绍或PPT里应该不错吧。以后做各种宣传资料不愁找不到量身定制的图片了。

如果不满意,可以基于该图片继续发问,例如,我们想看上面人体介绍的骨骼。提示词:可以详细展示骨骼介绍吗?

我们放大手部骨骼,继续提问:来一张手部骨骼的特写。

需要注意的是,图像的文字介绍可能比较模糊或混乱,这是因为中文提示的原因,如果使用英文会好很多。

那我们就用英文提示词来试一下,In a study filled with a retro atmosphere, on the corkboard beside the wooden desk, magnetic word - spelling cards fixed with colorful pushpins form a unique poem:

Line 1:"A melody"

Line 2:"Can wake up"

Line 3:"The slumbering memories,"

Line 4:"However, occasionally"(There is a large gap here)

Line 5:"On a silent night"

Line 6:"Will deepen"

Line 7:"That longing."

文字的嵌入和排列顺序还是相当不错的。

这个提示词的大意是,在一间充满复古氛围的书房里,木质书桌旁的软木板上,挂着用彩色图钉固定的磁性拼词卡片,组成一首独特的诗:第一行:“一段旋律” 第二行:“能唤醒” 第三行:“沉睡的记忆,” 第四行:“然而偶尔” (此处有较大间隔)第五行:“在寂静的夜晚” 第六行:“会加深” 第七行:“那份思念。”

上面只是一些非常简单、基础的玩法,有兴趣小伙伴可以体验一下非常棒。

对于新的文生图模型,OpenAI联合创始人兼首席执行官Sam Altman也给出了非常高的评价。

这是一项令人难以置信的产品。我还记得看到这个模型最初生成的一些图像时,很难相信它们真的是由人工智能创作的。我们认为大家会喜欢它,并且很期待看到由此激发的创造力。

这代表着我们在给予创作自由方面达到了一个新的高度。人们将会创作出一些非常了不起的作品,也会有一些可能冒犯他人的内容;我们的目标是,除非用户有此需求,否则该工具不会生成冒犯性内容,即便有此需求,生成的内容也需在合理范围内。

正如我们在模型规格说明中提到的,我们认为将这种知识创作自由和控制权交到用户手中是正确的做法,但我们也会观察其发展情况并倾听社会的声音。

我们认为,尊重社会最终为人工智能设定的广泛界限是正确的做法,而且随着我们离通用人工智能越来越近,这一点也变得越来越重要。在此过程中,感谢大家的理解。

新图像模型简单介绍

根据直播介绍,非自回归生成是OpenAI新图像模型的核心之一,是提升图片质量、生成效率的关键技术。

传统的图像生成方法,尤其是基于自回归模型的技术,通常是通过逐步生成图像的每个像素或部分来构建最终的图像。这种方法虽然在某些情况下能够生成高质量的图像,但其生成过程往往较为缓慢,并且容易在生成过程中出现累积错误,导致最终图像的质量下降。

此外,自回归生成方法在处理复杂的图像结构时也存在一定局限性,因为它们需要在每一步生成过程中都依赖于之前生成的内容,这使得模型难以全局性地理解和优化图像的整体结构。

相比之下,非自回归生成模块采用了一种全新的思路。不再依赖于逐像素的生成过程,而是直接生成整个图像。这一过程的关键在于模型能够一次性地理解和处理图像的整体结构和细节。非自回归生成模块通过一种特殊的编码器-解码器架构来实现这一目标。

编码器负责将输入的文本描述或其他模态信息转化为一种中间表示,包含了生成图像所需的所有关键信息。然后,解码器利用这种中间表示直接生成完整的图像,而无需逐像素地构建图像。

这种直接生成完整图像的方式带来了很多优势。首先,非自回归生成模块的生成速度远远超过了传统的自回归方法。由于无需逐像素生成,模型能够在短时间内生成高质量的图像,这对于实时应用和大规模图像生成任务具有重要意义。例如,在需要快速生成大量图像的设计场景或教育场景中,非自回归生成模块能够显著提高工作效率。

此外,非自回归生成模块在生成图像的质量上也表现出色。由于模型能够一次性地理解和处理图像的整体结构,生成的图像在细节和一致性方面都得到了显著提升。

例如,在生成复杂场景的图像时,非自回归生成模块能够更好地处理图像中的多个对象及其相互关系,生成的图像更加自然和逼真。此外,非自回归生成模块还能够更好地处理文本指令中的复杂语义信息,生成与文本描述高度一致的图像。

非自回归生成模块的另一个重要特点是其在多模态融合中的应用。在ChatGPT 4.0模型中,非自回归生成模块不仅能够根据文本描述生成图像,还能够结合其他模态的信息,如音频或已有的图像,生成更加丰富和多样化的图像内容。

这种多模态融合的能力使得模型能够更好地理解和满足用户的需求。例如,用户可以提供一段音频描述和一张参考图像,非自回归生成模块能够结合这些信息生成一张符合音频描述且风格与参考图像一致的新图像。

从今天开始,新的文生图模型在ChatGPT和Sora中开始向所有Plus、Pro、Team和免费用户推出。面向企业版、教育版和API即将到来。