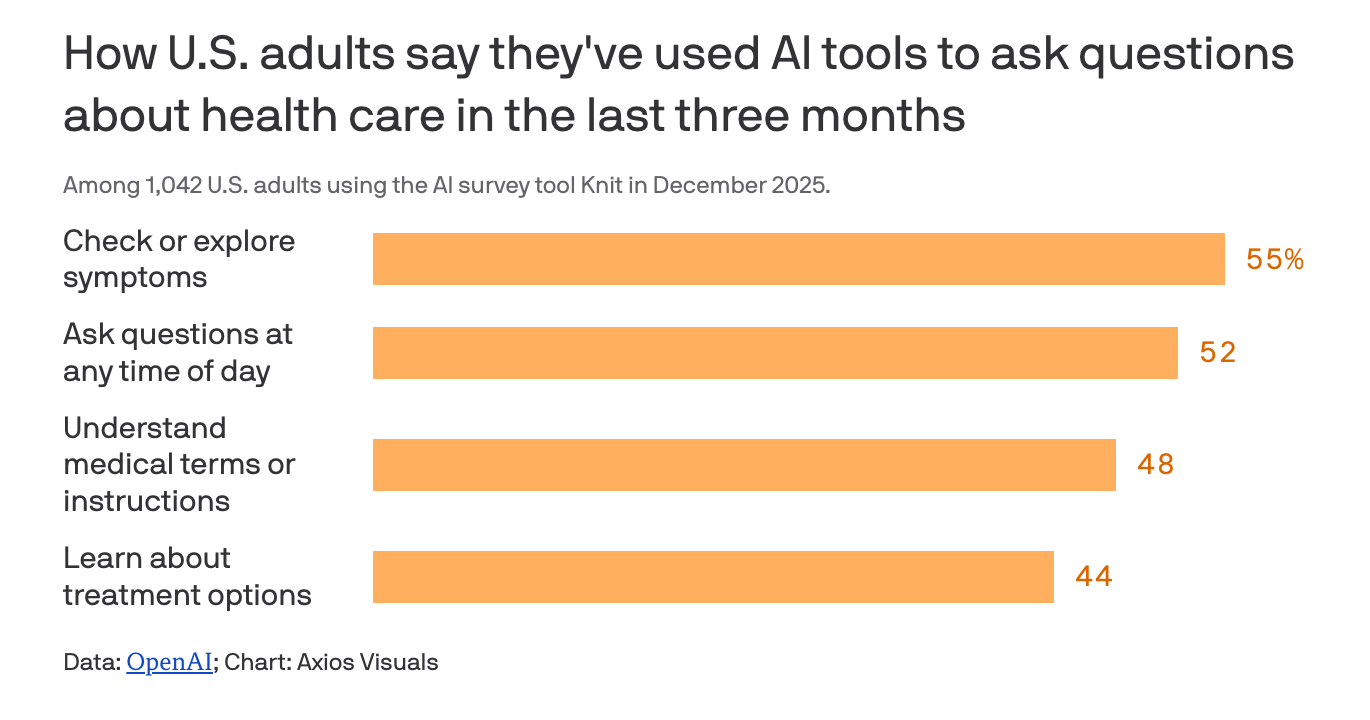

根据 OpenAI 向 Axios 独家分享的一份最新报告,每天有超过 4000 万美国人使用 ChatGPT 获取健康与医疗相关信息,借助这一工具在复杂而不透明的美国医疗体系中寻找方向。 在大量真实、匿名对话与配套问卷的分析中,患者普遍把 ChatGPT 视为在就医过程中帮助自己理解信息、做出决定的一名“盟友”,尤其是在面对专业术语、账单细目和保险理赔流程时,更倾向于先向聊天机器人“取经”。

用户常用 ChatGPT 来拆解医疗账单、识别多收费用、准备对保险拒赔的申诉材料,而在医生资源紧张、就诊名额有限的地区,一些人还会在无法及时就医时,用它进行自我初步判断或辅助管理自己的健康状况。

报告显示,与健康和医疗相关的对话已占到 ChatGPT 全球消息量的逾 5%。 OpenAI 的测算称,每周大约会收到 160 万至 190 万个有关健康保险的问题,集中在对比不同保险计划、处理理赔和账单争议以及其他各类保障条款咨询上。 在医疗资源相对匮乏的偏远农村地区,用户每周平均会发送接近 60 万条与健康医疗有关的信息,而大约七成的健康类对话发生在传统门诊时间之外,凸显出这一工具在“下班时间”补位在线问诊与咨询缺口的角色。

在具体使用场景中,患者往往会向 ChatGPT 输入自己的症状、此前从医生处获得的建议以及个人病史背景,系统则会结合这些信息,对某些情况的严重性给出风险提示。 在短期内无法获得就医机会的情形下,这类“预判”帮助部分用户判断,是可以等待门诊预约,还是应当立即前往急诊寻求面对面治疗。 OpenAI 在报告中强调,当回答建立在具体的个人背景之上——例如用户的保险计划文件、医生提供的书面指示以及医疗门户网站中的个人数据——其可靠性会显著提高。

然而,报告也点出了一面“现实检验”的镜子:ChatGPT 并非总是正确无误,在心理健康等敏感领域尤其可能给出错误甚至危险的建议。 目前,OpenAI 已因多起指控而面临诉讼,原告称其亲友在与该技术交互后受到严重伤害甚至选择自杀,由此引发外界对“责任边界”的持续追问。 多个州已经出台新法,专门针对 AI 聊天机器人在医疗场景中的应用,禁止相关应用或服务提供心理治疗决策支持等功能,试图用监管框架为技术划出“红线”。

与此同时,一些走红网络的案例正在展示另一种图景:越来越多患者将详细的医疗账单上传给 AI 工具进行逐项分析。 这些工具被曝屡次在账单中揪出重复收费、不当编码或违反联邦医保(Medicare)规则等问题,为患者与医院或保险方交涉提供了有力抓手。 此类故事在社交媒体上频频“出圈”,进一步强化了公众对 AI 在处理繁琐文书和规则方面的期待。

在幕后,OpenAI 表示,正在持续强化 ChatGPT 在健康场景中的应对方式。 公司称,会不断评估模型表现,以降低有害或误导性回答的风险,并与一线临床医生合作识别潜在问题、优化交互设计。 依照 OpenAI 的说法,新一代 GPT‑5 模型在健康对话中更倾向于主动追问补充信息、检索最新研究成果、使用更为审慎的表述,并在必要时建议用户寻求专业医疗评估,而不是停留在“屏幕上的答案”。

报道还指出,随着《平价医疗法案》(Affordable Care Act)强化补贴的到期,投保成本上升,未参保或保险不足的人群可能越来越依赖聊天机器人作为获取医疗建议的替代渠道,这一“静悄悄的转向”有望被加速推高。 在没有医生实时参与的情况下,未来围绕 AI 医疗建议的准确性、技术提供方与使用者之间的责任划分、以及对患者数据访问和使用规则的重塑,将成为美国医疗与科技监管领域持续关注的焦点。