售价超2000万的芯片系统 英伟达NVL72内部曝光

从分析师估计到首席执行官黄仁勋的评论,NVIDIA 的 Blackwell 平台的定价已经陆续出炉。简而言之,部署这些性能强大的产品将花费买家高昂的成本。摩根士丹利估计,NVIDIA 将在 2025 年出货 60,000 到 70,000 台 B200 服务器机柜,相当于每年至少 2100 亿美元的收入。尽管成本高昂,但对这些强大的 AI 服务器的需求仍然很强烈。

据报道,NVIDIA 已投资约 100 亿美元开发 Blackwell 平台,约有 25,000 人参与其中。由于所有性能都集成在单个 Blackwell GPU 中,因此这些产品的价格高昂也就不足为奇了。

据汇丰银行分析师称,NVIDIA 的 GB200 NVL36 服务器机架系统售价为 180 万美元,NVL72 售价为 300 万美元(约2175万人民币)。功能更强大的GB200 超级芯片结合了 CPU 和 GPU,预计每颗售价为 6 万至 7 万美元。这些超级芯片包括两个 GB100 GPU 和单个 Grace Hopper 芯片,并配有一个大型系统内存池(HBM3E)。

今年早些时候,首席执行官黄仁勋告诉 CNBC,Blackwell GPU 的价格为 3 万至 4 万美元,摩根士丹利根据此信息计算了买家的总成本。每台 AI 服务器机柜的价格约为 200 万至 300 万美元,而 NVIDIA 计划出货 6 万至 7 万台 B200 服务器机柜,预计年收入至少为 2100 亿美元。

但客户支出在某个时候会证明这是合理的吗?红杉资本分析师戴维·卡恩估计,支付其投资所需的年度人工智能收入已攀升至每年 6000 亿美元。

但目前,毫无疑问,无论代价有多大,公司都会付出代价。B200 拥有 2080 亿个晶体管,可提供高达 20 petaflops 的 FP4 计算能力。训练一个 1.8 万亿参数模型需要 8,000 个 Hopper GPU,消耗 15 兆瓦的功率。

这项任务需要 2,000 个 Blackwell GPU,功耗仅为 4 兆瓦。对于大型语言模型推理工作负载,GB200 超级芯片的性能是 H100 GPU 的 30 倍,并且显著降低了功耗。

据摩根士丹利称,由于需求旺盛,NVIDIA 将台积电的订单量增加了约 25%。可以毫不夸张地说,Blackwell 将成为AI 训练和许多推理工作负载的事实标准,它旨在为一系列下一代应用提供支持,包括机器人、自动驾驶汽车、工程模拟和医疗保健产品。

NVIDIA GB200 NVL72 系统细节

最近,我们有机会看到了 Supermicro 版本的 NVIDIA GB200 NVL72。

Supermicro NVIDIA GB200 NVL72 是 Supermicro 的 NVIDIA Grace Blackwell 200 NVLink 72 GPU 机架版本。

在顶部,我们看到了 Supermicro 的标志、网络和电源。

然后我们得到十个双节点 GB200 1U 机箱。

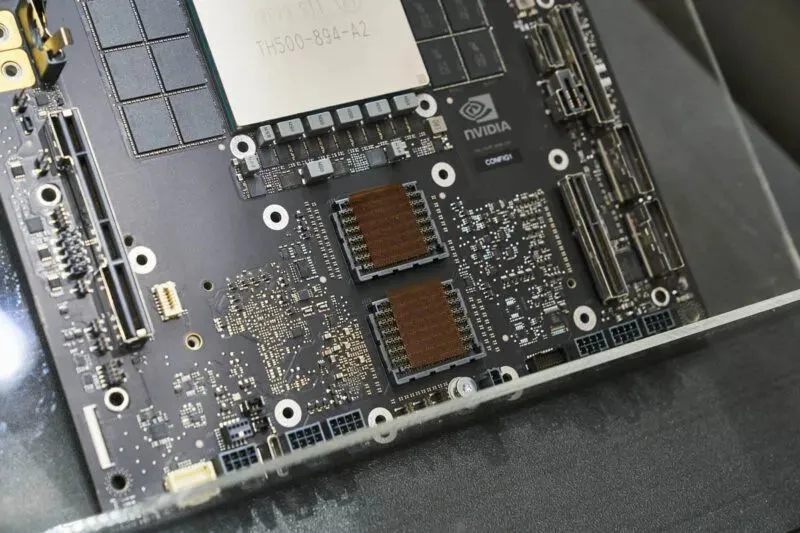

Grace Blackwell GB200 节点背面有用于连接 NVLink 背板的接口。这些节点为半宽节点,因此两个节点可以并排安装在 1U 机架式机箱中。

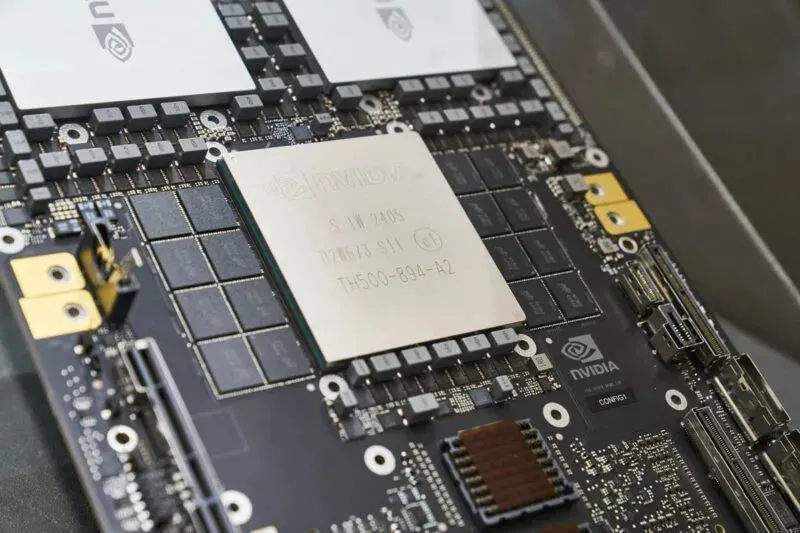

有两个 Blackwell GPU。

然后我们得到了带有 LPDDR 内存的 NVIDIA Grace CPU。

以及节点底部的 I/O 连接。

中间是用于连接系统的 NVLink 交换机。底部是另外八个双 GB200 节点。十八个 1U 机箱,每个机箱有两个 GB200 组件,每个组件有两个 Blackwell GPU,总共有 72 个 GPU。

下面是电源和由 Supermicro 制造的冷却剂分配装置。

这是一个与我们在 Supermicro 定制液体冷却机架中看到的设计类似的 CDU。

这个机架是一个集群,每小时使用约 120kW 的电量,大约相当于每小时的电量,这些电量存储在 123kWh 的特斯拉 Cybertruck 电池中。在视频中,我们讨论了 GB200 NVL72 机架如何像驾驶一辆约 7000 磅重的卡车行驶 300 英里。我们预计未来几个月内,更高功率的数据中心将使用这些 GB200 NVL72 解决方案。考虑到我们在液体冷却方面所做的努力,这是我们想要关注功率方面的原因之一。