微软重磅推出科幻感拉满的量子芯片 “AI+量子”时代渐行渐近

美国科技巨头微软(MSFT.US)于当地时间周三发布了一款全新量子芯片,微软称该量子芯片比竞争对手更少出错,该芯片是半导体和超导体的混合体,从外形上来看可谓科幻感十足,颇具科幻电影中的“未来主义风格”。并且微软表示这款芯片问世表明实用的量子计算距离现实“只有几年,而不是几十年”,这一预期与谷歌CEO桑达尔·皮查伊前不久的预测基本一致。

微软推出的全新量子计算芯片,可谓凸显出量子计算领域继谷歌Willow量子芯片震撼问世之后,迎来又一个关键里程碑。

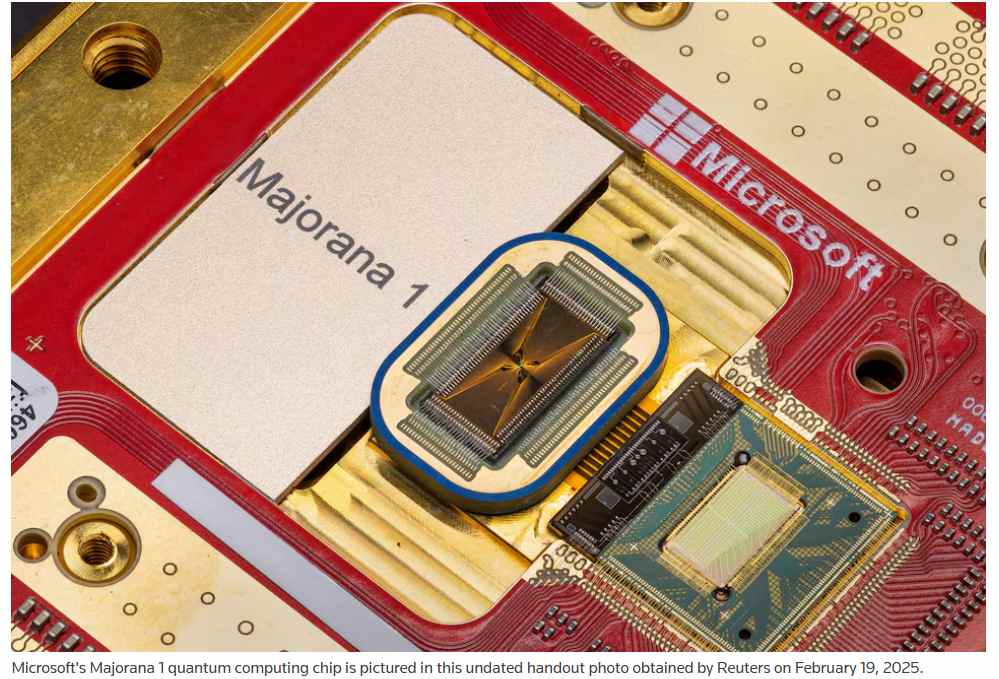

这一名为“Majorana 1”的微软量子芯片正式推出,也使得1月在官方博客称“2025年是量子就绪之年”的微软加入了谷歌(GOOGL.US)和IBM(IBM.US)所主导的量子计算核心硬件领域,并且这些科技巨无霸们均预测人类计算技术的实质性变革比人们普遍的进展要快得多。

“Majorana 1”震撼发布后有科技行业观察人士表示,量子计算可能不会成为微软旗下独立的计算业务部门,而是助力提升微软核心业务的技术发展路径,比如当前微软布局力度最大的人工智能(AI)领域。

随着此前问世的IBM Eagle芯片和Condor芯片等量子处理器,去年12月的谷歌Willow量子芯片,以及最新的微软“Majorana 1”展示在世人面前,量子计算加速所驱动的AI应用,比如融合量子计算的人工智能训练/推理算力系统,有望自2025年开始有望加速扩张,“融合人工智能(AI)与量子计算”的人类社会超级算力时代可谓渐行渐近。

量子计算有望执行当今传统的二进制计算系统需要数百万年才能完成的计算任务,并可能在生物医学、化学和天体物理学其他许多前沿研发领域中解锁新的理论发现,这些领域中的分子组合近乎无限,传统计算机难以应对。根据谷歌12月9日的一份声明,Willow量子芯片在基准测试中展示了惊人的性能,能够在不到5分钟内完成一个“标准的基准计算”,而传统超级计算机完成同样的任务需要“10的25次方年”。

然而,量子计算机也带来了颠覆当今网络安全系统的风险,因为大多数加密技术依赖于“暴力破解需要太长时间”的假设,而在量子计算面临所谓的“暴力破解”难度根本不存在。

构建实用级别的量子计算机的最大挑战在于其基本构建模块——量子比特(qubit)。量子比特类似于经典计算中的比特或者位,但其速度极快,同时稳定性对于目前人类量子科技水平来说也极难控制且非常容易出错。

不过微软在最新声明中表示,其开发的Majorana 1量子芯片比竞争对手的量子芯片更少出错,并提供了即将发表在顶级学术期刊《自然》上的科学论文作为证据。

不过需要注意的是,包括谷歌和微软在内,目前还没有任何公司实现任何意义上可精准控制量子态且能够实现大规模商业化的实质用途级别“量子计算”。这也是为什么谷歌首席执行官在一份帖子强调Willow量子芯片为“迈向打造实用量子计算机的重要步伐”,这也意味着谷歌在距离实现可控且商业化的“量子计算”也有着一段距离。

目前人类技术无法以通用的计算体系实现对于量子态的精准与稳定控制,尤其是在实现精准且可控的“量子纠缠”方面存在很大的技术瓶颈。量子纠缠是量子计算的关键特性之一,它允许量子比特之间的超强关联,这对于海量并行计算和解决某些问题至关重要。量子计算的商业化进程需要解决量子错误修正、量子比特的稳定性等一系列技术挑战,以及需要纠缠深度与规模可控,且精准实现对于商业化而言最核心的特殊量子态——量子纠缠。然而,当前技术尚未能够实现大规模、长期稳定的量子纠缠。

布局量子计算的科技巨头越来越多,量子领域的“Transformer时刻”越来越近

实用量子计算的到来时间成为美国科技行业高层间的热议话题。英伟达(NVDA.US)首席执行官黄仁勋的观点与谷歌和微软则有所不同,“皮衣刀客”黄仁勋上个月曾表示,实用的量子计算技术距离超越其公司的人工智能芯片算力系统还有20年-30年的时间,这反映出在科技行业广泛存在的怀疑态度。

黄仁勋的言论促使量子计算领域领军者集体反击,在去年展示其新量子芯片的谷歌表示,可商业化的量子计算应用距离现实只有五年左右的时间。IBM则表示,大规模量子计算机集群将在2033年上线。D-Wave Quantum(QBTS.US)与IonQ(IONQ.US)对于黄仁勋的反击点在于他们已经实现了具有“实际用途的量子计算应用”,事实证明确实如此,但商业化范围极度狭窄。

但不可否认的是,越来越多科技巨头加大力度布局量子计算领域,英伟达创始人兼CEO黄仁勋似乎打从心底看好量子计算发展前景,欲成为量子计算领军者之一,这可能是为何距离他发表上述的这番话不到一周时间,英伟达官宣将在于3月17日至21日的GTC大会上举办首个“量子日”(Quantum Day),黄仁勋届时将与行业领袖们同台探讨量子计算最新技术进展。几乎同一时间,微软也为量子计算“打call”,在官方博客称2025年是“量子就绪之年”。

据悉,微软的“Majorana 1”量子芯片已经研发了近20年,依赖于一种被称为Majorana费米子的亚原子粒子。这种粒子在20世纪30年代首次被物理学界理论化,其特性使其不易出现量子计算机常见的错误,但物理学家们一直难以精准找到并控制它。

微软的Majorana 1芯片采用砷化铟和铝金属所制成,该计算设备使用超导纳米线来观察粒子,并可以通过传统的标准计算设备进行控制与执行。

虽然微软周三发布的量子芯片的量子比特数量远少于谷歌和IBM的竞争对手芯片,但微软认为,由于其错误率低得多,基于Majorana 1芯片的量子比特数量将大幅减少,从而制造出实用的大型量子计算机。

微软没有给出该芯片扩展为能够超越当今传统机器的量子计算机的时间表,但该公司在一篇博客文章中表示,这一时刻“只有几年,而不是几十年”的距离。

负责微软长期战略投资的执行副总裁杰森·赞德将Majorana 1描述为“高风险、高回报”的研究战略。

微软表示,这一科幻风十足的量子芯片由华盛顿州和丹麦的微软实验室所制造。

“最困难的部分是解决物理问题。我们没有任何教科书可供参考,必须依靠研发团队来进行解决。”赞德在接受媒体采访时表示。“我们实际上发明了逐个原子、逐层制造这种新事物的能力。”

哈佛大学物理学教授菲利普·金(未参与微软的研究)表示,Majorana费米子数十年来一直是物理学家们的热门讨论话题,并称微软的工作是“令人兴奋的进展”,使该公司处于量子研究的最前沿。

他还表示,微软使用传统半导体和奇异超导体混合的方法似乎是制造可扩展为更强大量子芯片的良好前沿途径。“虽然还没有扩大规模的实际证明,但他们所做的一切真的很成功。”

Transformer架构的横空出世标志着深度学习与人工智能领域迎来了新的范式转变,可谓直接推动了ChatGPT等生成式 AI应用软件的诞生,正是Transformer以及能够高效运行该架构的硬件算力体系将“生成式AI”从谷歌AI实验室带向商业应用。后来的 GPT 家族所有AI大模型,以及Gemini、Claude与LIama等大模型都是基于 Transformer 架构,堪称“AI大模型之母”。展望量子计算的未来,所谓的“Transformer时刻”距离人类社会渐行渐近。

量子计算的“Transformer时刻”,即指代“基于量子计算技术所打造出的可控的、具有大型商业价值的量子计算应用系统”,这里的量子计算包括但不限于离子阱、量子退火、量子模拟、超导量子比特以及量子纠缠与拓扑量子等等。目前人类技术无法以通用的计算体系实现对于量子态的精准与稳定控制模式,尤其是在实现精准且可控的“量子纠缠”方面存在很大的技术瓶颈。

但是近年来离子阱技术(比如IonQ、霍尼韦尔的量子解决方案)、D-Wave量子退火计算机等量子计算领域取得突破式进展,IBM力争融合量子比特与二进制算力硬件基础设施,再到2024年12月,谷歌 Willow震撼发布,以及名为“Majorana 1”的微软量子芯片问世,量子计算领域似乎出现类似的“范式转变”重要基础,使得量子计算有望从物理书上的纯理论逐渐走向“可控的、具有商业价值的实用量子计算应用系统”。

随着英伟达与微软这两大科技巨无霸,以及此前公布量子蓝图的亚马逊官宣入局,再加上谷歌与IBM多年以来深耕于量子计算底层理论与量子硬件体系,以它们的人才储备以及庞大资金体量,再加上各国政府近年来的强力支持,或将推动量子计算商业化的轨迹步入加速曲线。

量子计算——推动人工智能发展的核心力量

量子计算的未来,大概率将是加速人工智能算力发展的核心引擎。量子计算不仅可以加速AI大模型训练过程,解决AI推理系统中一些依靠传统算力无法解决的计算难题,甚至有可能在未来通过量子神经网络等融合“AI+量子”的全新技术推动更高效的人工智能大模型开发,加快AI人形机器人以及所谓的AGI等人工智能时代最具颠覆性质的“赛博朋克式产品”渗透至全球。

量子计算基于量子力学的原理,与传统的经典计算截然不同。量子计算机使用量子比特,而非传统计算机的二进制位,并且量子比特能够利用量子叠加、量子纠缠和量子干涉等量子基本特性来进行计算。这使得量子计算具备巨大的并行计算能力和指数级加速能力,这些能力对于人工智能训练/推理系统的发展以及全面推向市场来说可谓提供宛如“开挂”般的助力,未来与人工智能应用相关的成本有望大幅下降且可能实现在极短时间内将人工智能大模型以及所谓的“具身AI”——主要包括AI人形机器人,覆盖至全球大部分地区,带来一场“工业革命级别”的人类生产率升级浪潮。

比如传统AI大模型在处理数十亿到万亿级别的参数时需要极高的计算能力,这也使得AI大模型的训练和部署成本非常昂贵。大模型通常需要在巨大的参数空间中进行探索,而量子计算能够利用量子叠加性在这些高维空间中快速找到有用的解。“量子神经网络”则是一种结合了量子计算加速模式和神经网络的混合架构,它能够利用量子比特的叠加和量子纠缠性质,将使得神经网络的训练与推理范式更加高效且精准。

“AI+量子”目前处于最前沿研究与探索领域,这两者的深度融合,或将是量子计算这一全新加速机计算模式落地大规模实际商业用途的最终目的地。目前“AI+量子”最大难题在于硬件端,如何设计出一个架构能够完美整合二进制硬件算力基础设施以及基于量子位的量子计算基础设施。

这也是为何英伟达已经开始布局所谓的“QPU”(即量子芯片)平台,比如开源的量子-经典混合计算平台CUDA Quantum,旨在将量子计算硬件与传统计算资源(如GPU和CPU)结合,允许开发者们在同一系统中集成和编程量子计算芯片、GPU和CPU,通过CUDA Quantum,谷歌等量子芯片开发者们将能够模拟基于量子计算设备的物理特性,帮助解决量子操作中的噪声、量子错误、比特稳定性等问题。

对于人类研发进程的推动,“AI+量子”比单纯的AI或者单纯的量子计算更具革新意义,量子计算能够模拟传统计算机无法高效模拟的复杂量子系统。结合人工智能,对于药物设计、材料科学和分子模拟等领域的研究具有极其重大的意义,大模型将能够借助“量子计算加速范式”,实现更快速地处理复杂模型,从而推动医药、生物科技、气象预报以及能源等行业的创新步伐呈现指数级加速。