下一代HBM4到HBM8:迈向15000W加速器上的多TB内存

在本周的联合简报会上,韩国科学技术研究院(KAIST)内存系统实验室和 TERA 互连与封装团队展示了高带宽内存 (HBM) 标准及其加速器平台的前瞻性路线图。该路线图涵盖了从 HBM4 到 HBM8 的五代产品,每代产品都有望在容量、带宽和封装复杂度方面实现大幅提升。

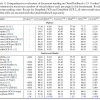

首先是 HBM4,计划于 2026 年在 AI GPU 和数据中心加速器中推出。它将通过 2048 位接口以 8 Gbps 的引脚速率提供每堆栈约 2 TB/s 的数据传输率。芯片堆栈将达到 12 至 16 层,每个封装可提供 36-48 GB 的容量,功率范围为 75 W。 NVIDIA 即将推出的 Rubin 系列和 AMD 的 Instinct MI500 显卡预计将采用 HBM4,其中 Rubin Ultra 将内存堆栈数量从 8 个增加一倍至 16 个,AMD 的目标是每台设备高达 432 GB。

展望 2029 年,HBM5 将保持 8 Gbps 的速度,但 I/O 通道将翻倍至 4096 位,每个堆栈的吞吐量将提升至 4 TB/s。使用 16 层 40 Gb 芯片堆栈,功耗将升至 100 W,容量可扩展至 80 GB。NVIDIA 的 Feynman 加速器预计将成为首个采用 HBM5 的产品,它将 400-500 GB 内存封装在一个多芯片封装中,总功耗超过 4400 W。到 2032 年,HBM6 将使引脚速度翻倍至 16 Gbps,并将带宽提升至 8 TB/s,通道数超过 4096。堆栈高度可增至 20 层,每堆栈最高支持 120 GB 容量,功耗为 120 W。浸入式冷却和无缝铜-铜键合将成为常态。

路线图预测 2035 年将推出 HBM7,其速度可达 24 Gbps,接口为 8192 位,吞吐量为 24 TB/s,每堆栈最高支持 192 GB 容量,功耗为 160 W。NVIDIA 正在准备一款 15360 W 的加速器来支持这一庞大的内存。

最后但同样重要的是,HBM8 将于 2038 年问世,其速度高达 32 Gbps,拥有 16384 个通道,存储容量为 64 TB/s,堆栈容量为 200-240 GB,并配备 180 W 的嵌入式冷却系统。除了纯 DRAM 之外,此次简报还预告了混合HBM-HBF(高带宽闪存)架构,以满足大规模 AI 推理的需求,该架构通过超高速硅通孔将基于 NAND 的闪存与 DRAM 堆栈配对。随着加速器向 PB 级带宽和多芯片设计方向发展,这些新兴的 HBM 和 HBF 标准是唯一的发展方向。