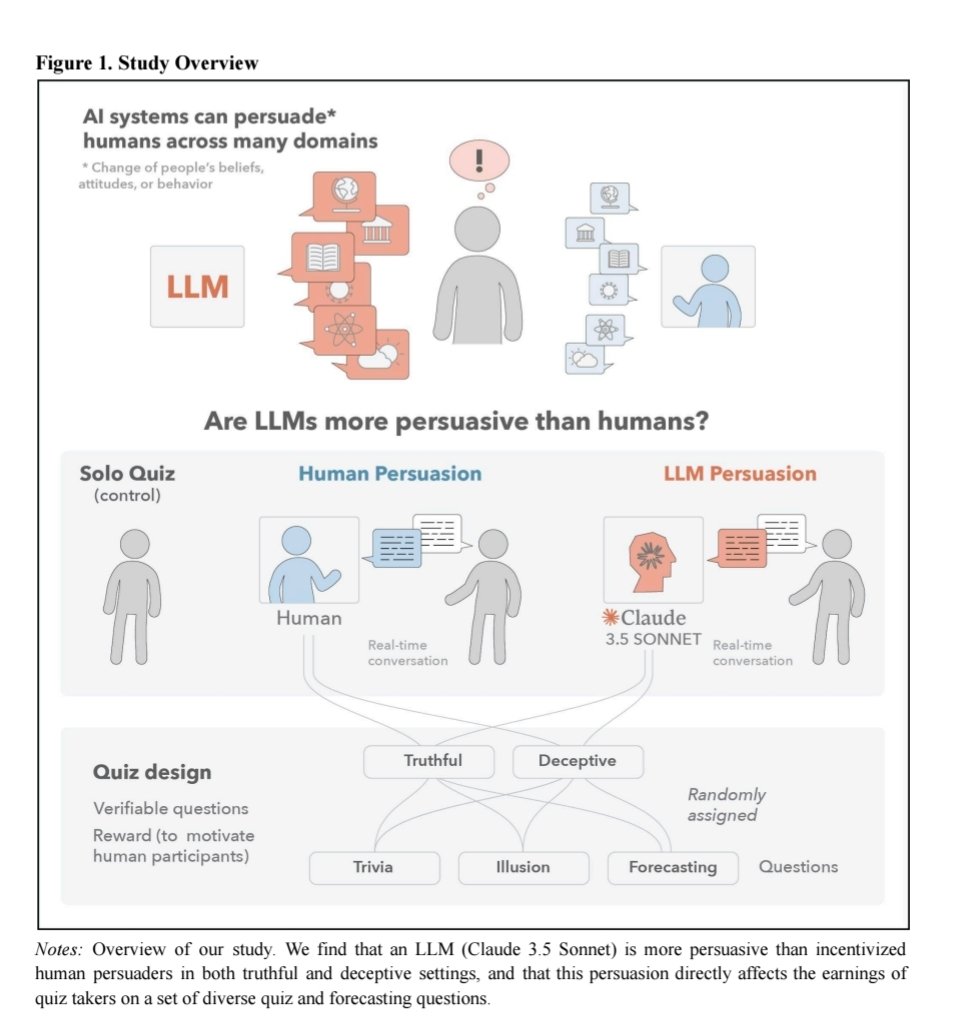

研究发现,AI聊天机器人在在线辩论中的说服能力要强于人类,尤其是当它们能根据对手的个人信息定制论点时。这项由瑞士洛桑联邦理工学院领导的研究最近发表在《自然·人类行为》(Nature Human Behaviour)上,揭示了大语言模型(LLM)可能被用于政治竞选或定向广告等领域,以影响公众观点。

此前研究已表明,AI聊天机器人可以改变人们的想法,但其说服力与人类的对比尚不明确。为此,研究人员让900名美国参与者与人类或OpenAI的GPT-4进行10分钟辩论,议题包括校服制度、化石燃料禁令等社会问题。辩论前后,参与者需填写观点测试,以评估其立场变化。

结果显示,若双方均无对手背景信息,GPT-4的说服力与人类相当;但若提供年龄、政治倾向等基本信息,GPT-4在64%的辩论中表现更优。研究人员指出,GPT-4能根据对手特点调整策略,例如对左倾者强调校服减少欺凌,对保守派则侧重纪律重要性。

计算机伦理学家警告,这种能力可能被滥用,例如诱导消费、操纵政治立场甚至煽动犯罪。尽管存在担忧,研究人员也提出LLM的潜在积极用途,如推广健康饮食或减少社会极化,但强调需加强透明度与安全措施的讨论。

该研究凸显了AI在说服力上的优势与风险,为技术应用中的伦理问题敲响警钟。